第十二期CCF-CV“视界无限”系列研讨会成功举办

2022年1月5日,由中国计算机学会计算机视觉专委会联合百度视觉技术部、增强现实技术部举办的第12期CCF-CV“视界无限”系列活动——“智能内容创作(AIGC)前沿进展与未来趋势” 研讨会在百度科技园成功举办。研讨会邀请了百度集团副总裁吴甜、专委会副主任中科院自动化所王亮研究员致辞,中科院自动化所赫然研究员、北京大学刘家瑛副教授、北京航空航天大学刘偲教授、清华大学刘烨斌副教授、清华大学刘永进教授和微软亚洲研究院杨蛟龙研究员做主题报告。百度视觉技术部首席架构师王井东及以上六位讲者参与了深度研讨。计算机视觉专委会B站公众号对本次会议进行了全程直播,直播人气峰值达到2000+。

百度集团副总裁吴甜在开场致辞中回顾并梳理了内容生产的发展历程,无论在互联网出现之前还是之后,内容的载体一直在升级变化,但人类社会对内容的需求是一直存在的。AIGC 的内容生产方式近年来备受关注,背后主要有两大推动力:一是需求层面,数字世界对大量高质量、个性化、有创意的内容需求日益增加;二是 AI 相关技术发展,如超大规模知识图谱、计算机视觉、语音、自然语言处理、生成大模型等技术的融合创新发展。吴甜表示,目前在内容创作过程中,AI 更多发挥的是辅助创作的作用,要想完全运用 AI 技术自主制作内容还有很长的路要走,也还有很多可以探索的工作。她提出对于AI技术而言,AIGC目前面临着三大挑战,即模仿和超越人类的创意、增加对人类认知和逻辑理解多样性的准确判断、降低制作高精良内容的成本并缩短周期以实现规模化。

王亮副主任向大家介绍,本次研讨会是计算机视觉专委会举办的“视界无限”系列活动第十二期,既是 2022 年开年的第一场活动、也是第一次由企业承办的“视界无限”,非常有意义。王老师指出, AIGC 智能内容创作是当前最前沿和活跃的研究方向,具有非常广阔的应用前景,近年来该领域的研究和应用也开展得如火如荼。不过这一领域一方面发展得很快,另一方面也存在很多实际的困难和挑战。借由本次活动,大家可以与该领域的优秀专家学者就目前研究现状做一次梳理和交流,一起探索未来可能的发展趋势。最后,王亮副主任还对百度公司、研讨会组织者以及各位青年学者表达了感谢,并预祝本次会议成功举办。

赫然研究员的报告题目是“人脸图像合成与鉴别”。人脸图像合成是指使用深度学习等智能化技术对人脸图像数据进行修改、编辑和替换,进而创造出从身份内容或表观纹理上完全不同的图像。人脸图像合成及其鉴别是机器学习和计算机视觉等领域的重要研究内容之一,被广泛应用于影视媒体娱乐和人工智能安全,在国家公共安全领域具有重要研究意义。赫然研究员的报告结合人脸图像合成的实际应用需求,介绍“合成”与“鉴别”相辅相成、“攻击”与“防御”相互促进的对抗博弈机制;从信息理论角度探寻深度合成的信息交换本质,介绍表象最优传输和信息瓶颈解表达等生成模型,以及全脸生成、属性编辑(年龄、光谱、样式)、身份交换、人脸重演(表情、姿态)、语音驱动人脸等合成方法。

刘家瑛副教授的报告题目是“智能艺术生成与美学计算”。数据驱动下基于生成技术的影像与美学计算研究飞速发展,本次报告以图像风格化和生成技术在智能影像编辑与生成建模领域的应用为主线,分享了刘家瑛副教授研究小组围绕文字风格化艺术生成、基于手绘的人脸编辑等方面的探索,重点介绍基于生成对抗网络的文字风格化与去风格化技术、形状可变的风格化文字生成技术等一系列相关研究工作。

刘偲教授的报告题目是“多模态内容生成”。在报告中,刘偲教授介绍了视频自动配乐、语言指导的图像编辑两种多模态生成方法。在视频自动配乐方向上,刘偲教授团队首先建立了视频和背景乐的韵律关系,并提出了可控的音乐 Transformer 生成模型,能够按照用户指定的音乐流派和乐器,实现音乐和视频的一致性。在语言指导的图像编辑方向上,团队提出的方法主要包含 2 个模块:编辑描述模块,即可以给定任意一对图像,输出其之间的编辑嵌入表述;图像-语言注意力模块,即能够根据语言自适应地编辑图像。在这一方向上,刘偲教授团队也提出了一种新的评价标准。

刘烨斌副教授的报告题目是“数字人技术——交互性、沉浸性及创造性”。在元宇宙和人工智能热潮下,基于神经网络的数字人重建与生成技术受到学术界和工业界的广泛关注。围绕真实人物对象的三维重建、运动捕捉和智能生成成为构建现实世界和虚拟世界间的桥梁技术。此次报告围绕智能数字人的 3I 技术,即人的行为感知实现交互性(Interaction)、人的外观重建实现沉浸性(Immersion)、赋予人的思想实现创作性(Imagination)分别介绍了刘烨斌副教授在人体运动捕捉、人体动态三维重建、人体视频高质量生成等三方面的科研工作,涵盖人体、人脸、人手等相关视觉图形学前沿技术。报告同时对沉浸式全息通信技术、AI数字人等前沿热点进行了展望和探讨。

刘永进教授的报告题目是“虚拟人智能体的人机共情研究”。共情是社会互动中个体理解他人立场、并产生与他人相似情感的心理推理形式,是人类合作行为的主要动机来源。目前虚拟形象技术研究在计算机图形学、计算机视觉和社交多媒体领域受到越来越广泛的重视,新颖的虚拟形象技术正在不断的提出。此次报告就人能否准确理解虚拟形象的情绪,并从让虚拟人智能体能够产生和人一致的情绪反应与让用户能够产生和机器一致的情绪反应两个角度开展研讨。

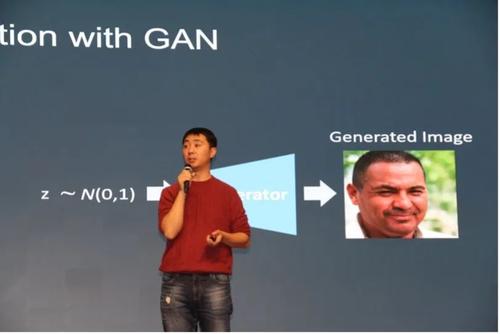

杨蛟龙研究员的报告题目是“跨越维度鸿沟——三维可控的图像生成研究”。二维图像是三维空间中物体的投影。目前生成对抗模型已经可以生成逼真的二维图像,然而其生成过程并不感知所生成内容的三维形态,对生成内容也不能进行三维空间中的控制,如视角控制、形状变化等。本次报告中,杨蛟龙研究员以三维可控图像生成和编辑为主题,分享了其团队在基于解耦合 2D GAN 的三维可控人脸图像生成、基于神经辐射场(NeRF)的三维视角可控图像生成、单幅人像视角和表情编辑、多视图人体图像实时任意视角合成等一系列相关研究方向上的工作成果。

在 Panel 环节,与会嘉宾就“人脸编辑、迁移、风格化的技术发展、现状和挑战” “数字人相关技术应用趋势与难题” “ 视频配乐生成原理与发展方向” “ 对人机交互领域技术前景的预测” “ 智能创作领域的客观评价标准” “AI 驱动虚拟人到真人驱动虚拟人的距离” 等问题展开热烈讨论,各位专家就上述问题分享各自的观点。

Panel 实 录

王井东:非常感谢6位老师的精彩分享,这真的是一场视觉盛宴,不仅是技术上非常丰富,同时大家可以看到很多非常漂亮的图片在里面,这正是我们AIGC的目标。然后下面我们开始讨论,大家看到每位老师讲的工作里面都多多少少跟人脸相关。我们第一个议题就是请大家探讨一下人脸目前的技术进展是怎样的。大家之前也谈到了一些,但更多的是谈论自己的工作,我建议大家可以从全局的整个研究领域的方面,谈谈技术的发展、现状以及挑战,特别是如果我们要把人脸相关的技术用到实际问题里还具有哪些挑战,哪些技术是可以落地的,哪些技术还不能,哪些技术落地了,但是规模化还存在一些问题。好,我们先从家瑛开始。

刘家瑛:其实我不算是做人脸,但是刚才也涉及到了一些相关内容,我觉得我能想到的相关工作有两点,一方面就是围绕人脸这种特定场景做同时面向机器视觉和人眼重建的图像视频压缩,也就是VCM(Video Coding for Machine)相关内容。其中我感觉很重要的问题就是生成的算法的评价问题。可能对于人脸来讲,刚才两位老师提问赫老师的时候,提及说怎么样好看不好看是一回事,还有一个identity保持这个问题可能也是一个一定程度上目前这种生成技术下的一个比较困扰性的问题。以VCM为例,既希望码流压的非常小,但同时希望能够保持人眼观看的质量,同时又能够在指标上满足说它在检测或者是一些high-level vision task上的识别度是足够高的,把这几件事情关联起来,我觉得至少从我的视角上它可能还是一个值得去探讨的问题。然后第二个的话从我作为用户的角度上来讲,因为我也尝试使用一些P图软件去修改人像照片等,我理解其实现在的交互还是会有点复杂,比如刚才秀的Demo,我感觉从我作为第一用户,关于这种视频会议的诉求,其实倒不需要他一直注视我,我希望我的诉求是如果我低头了,但是比如说我带着学生上课,突然有什么emergency,个图像还可以始终保持在一个不是有什么异样的状态,我觉得这对我来说是刚需。当然现在这种因为疫情下这种新的状态,我觉得这种数字人其实还是蛮需要,因为大家可能需要有这种交互感,但这个交互感到底是什么其实也是一个很有趣的问题,大致我就是有这样两方面的思考。

赫然:我觉得在计算机视觉里面人脸可能是一个相对比较简单的问题。从2011年的人脸检测,逐渐解决人脸检测的问题,到深度学习之后基本上解决人脸识别的问题,所以人脸基本上就是我们智能手机所必备的一个图像处理功能,也一直是工业界学术界研究比较多的一个方面。学术界的话去年CVPR投稿最多的是人脸方面的,也是竞争最惨烈的,说明人脸还是研究比较热的一个点。在工业界,各大公司包括短视频公司关注的还是人脸,因为这个是较大的消费内容的部分。这是我们日常要关注的问题,所以整体来说人脸还是比较热的一个方向,各方面投入比较多,这里面技术发展很快,在两年前大家写文章的话人脸模型可能还会崩,现在有预训练的模型之后生成图像基本上质量都非常好,而且在我们手机APP里面,换脸软件基本上就是必备的功能,换的效果都会很漂亮,像不像不好说,但是基本上都会换的比较好看了。整体上技术的进度比较快,这里面还有很多问题值得深入研究,比如说光照问题是解决不太好的一个。还有3D重建,怎么样能精确重建出来,肯定也是一个很难的问题,因为本身来说人脸是2D的,然后3D信息是三维的,增加了一个维度之后,怎么样能够在小成本下,在我们手机里面实现人体人脸的重建。然后另外一个就是说现在图像上的话效果比较不错,视频的话还是比较难的。因为生成一个换脸视频或者视频会议,这个效果是比较难的。还有精细化的控制,当然这个精细化的控制跟3D直接相关。

刘烨斌:人脸这一块确实是视觉的一个很活跃的地方。目前来说,从三维的角度来说,像人脸的capture动捕,人脸表情的捕捉,在像手机上有很多应用,当然目前还是很难去捕捉人的细微的表情,并且animation这一块也做的不好。所以现在的一些方法是一个data,针对person的specific的方法,能解决一个问题,就是大规模的针对这个人去做,我觉得通过多视点,然后一些采集,应该可以把人脸的animation在未来做一些像AR和VR的应用。另外一块现在很多,是基于人脸的生成,人脸生成像刚才蛟龙做的工作很好,做这个视点一次性的生成,包括identity怎么恢复,可能这些我觉得在近几年就有很大的进步。最后这块怎么样能应用起来,我觉得也是需要思考的。我觉得这里面有一个问题,就是如何从单图像去获取一个更好的三维的结果,因为我们现在很多都是偏向生成人脸,可以生成高精度的头发、牙齿或者舌头,这些东西实在是非常困难的事情。然后你只有把geometry能做好,才能做好元宇宙的一些应用,包括各类的animation等等,而且它也可以辅助图像。当然现在的一种思想是通过NeRF或者通过图像的渲染,也是一种思路,未来可能在geometry上我们要更投入一点。

刘永进:人脸这个方面其实我算是半路出家,以前我是做几何的,人脸确实比较重要,所以近几年也开始涉及到这方面。其实我觉得像前面几个老师可能更权威啊。我个人的一些理解就是人脸其实在神经科学里面,脑驱当中专门有一部分去负责处理,它的语义性特别强。自然图像的草地或者天空,它的颜色稍微变化一点,也没有那么凸显,但是人脸上只要有一点点瑕疵,他这个人马上就能察觉出来,恐怖谷效应大家都非常清楚,它的语义性特别强。所以我个人感觉其实是两方面,一个是真实版的人脸,恐怖谷效应是会特别的显著的,当它离真人越来越近的时候,稍微有一点点瑕疵就会特别明显,这不管是三维的还是二维,另外一方面除了真实的人脸,还有非真实版的人脸,包括肖像画、卡通画,包括一些风格化的处理,这方面就跟审美艺术是有关系的。那么另一个方面也是一个很有趣的话题,就是说如何做到形似而神不似,就是画出来的一些素材明显跟真人差别很大,但是你又能感觉到它原来跟ID之间是有某种关系的,对吧?此外如果从学术研究上来看的话,多模态之间的可解释性可能也是一个,比如说人脸生成二维三维识别图像,视频可能是一个点。此外还有从语音文本自然语言处理的一些交互是一个点,比如说现在去做这种语音驱动的头动或者人体动作,比如说你用数据驱动的方法,我觉得有很大的问题就是说你只要有数据,你有标注都可以训练出来一个东西,但这个东西是不是真的有它的物理的这种机理其实不清晰。很多时候我们都在想,比如说你用语音来驱动唇形,其实它是有生理学基础的,因为什么呢,因为发音就会有这种喉咙控制肌肉,只要喉咙发音就会有脸部肌肉控制它,所以脸部就会有表情,所以表情和语音之间是强耦合的,这是有生理学基础的,但是如果说我们用语音来做头动或者用语音来做人体动作,那么语音跟这个人体动作之间它是强耦合还是弱耦合?当然只要你有数据,可能做一个标注也可以训练,但是训练是不是有道理的,其实这方面也可以有一个探究,多模态之间的这种协同,我觉得人脸这个话题还是有很多的内容可以尝试的。

刘偲:我其实也不是专门做人脸方向,像各位老师的paper,我都学习过很多。算下来这些年我做过人脸相关的内容,主要是两个方面,一个是把人脸变老变年轻的工作,在17年的时候大概做过一段时间,就像赫然老师说的,当年我们用GAN做特别容易有模式坍塌的问题,看它训着训着就崩了。现在我也关注了相关方向的论文,这个问题已经好很多了。另外一系列工作,是我比较喜欢的美妆,一直在做make up transfer。在做完美妆的project之后,确实也有一些短视频公司联系到我们,希望把它用在一些比较火的短视频平台,后面确实有一些落地,当然他们不完全是用我们的方法,也用一些传统的方法。因为有的时候或许不一定要用深度学习或者最新的方法,可能在产业界用那种图像处理的方法也挺好,这个是我的一个感触。另外可能我们很多都是做人脸生成的工作,那另外一个很重要的任务就是鉴伪了。我看到赫然老师也做了很多关于如何鉴伪的工作,我认为这也是很重要的一个方向。

杨蛟龙:这个问题是关于人脸在产业界的应用,我分享几个我的观点,不一定对。首先我觉得人脸生成用来做高层的视觉任务基本没用,他只解决一个问题就是数据隐私,所以随着大家现在对人脸隐私越来越关注,包括中国也开始立法,欧洲早就有GDPR。如果抛开这个问题不讲的话,真实数据基本上标注好了之后所有的高层视觉任务,比如识别、检测之类的生成没用。其次是在其他工业界这方面的话,首先关于影视业这个是很明显的,我觉得将来人脸生成会在里面有很大用,肯定现在也已经用起来了,不过我相信你现在看一些大片,最后肯定还得人再调一下,但是可能已经显著降低工作成本。其次就是换脸对吧,大家用的美妆、换卡通形象等等,这个肯定也用起来了,而且体量其实挺大的,短视频的平台这么多,基本上在这里面肯定也是有用的。然后还有一个很大的空间,就是我们现在正在做的关于虚拟人、人像的生成,然后像我们最近在做的工作,当然还有问题需要解决,但可以想象快到真的可以实现产业级应用的一个程度了,这方面我觉得以后的想象空间很大,不管是不是元宇宙,但这个需求肯定是有的。这方面应该应用比较多,就这么几个浅薄的观点。

王井东:谢谢,刚才说已经都用起来了。从你的角度考虑,这个用起来是自动的完全用起来还是加了很多人工的交互。

杨蛟龙:首先我不是这个行业的,我肯定了解的不是很清楚,但如果让我猜一下,现在全自动的如果容忍度比较高的话,那是可以完全自动的,要真的达到影视级别,不手调我个人理解不可能。

王井东:其实也有一些电视因为某种原因演员当初演了这个节目,但是后来某种原因也被换了。那样的东西,从你的角度考虑是自动的吗?

杨蛟龙:我说多少百分比呢,我觉得不可能是那种全自动,就给出个大概,然后人再上去每一帧稍微调调,可能就够了,但是那个工作也是需要一些工作量,人不可避免是要有些交互的。

王井东:对,刚才蛟龙和前面几位老师也提到了虚拟人或数字人技术,其实大家可能最近也在江苏卫视跨年会上看到周深和邓丽君的一个跨时空的合唱,对吧?很多人在讨论,包括我也看到有一个视频叫未来新世界,也有一些我们做技术的人,然后也有跨界的参加最强大脑的王昱珩。然后他们做了这么一个投票,因为在这个视频里面邓丽君不仅仅是唱歌表演,也和嘉宾有交互。这个涉及到和刘永进老师相关的共情甚至交互等等。有个投票说是你认为邓丽君能不能和你很自然的在语言表情各方面交互,去做个投票,会怎么样呢?

刘永进:这个我真的是非常好奇,因为说不好,我觉得如果说能有机会让我去试一下,我个性化的一些输入,能给我一些个性化的反馈,对不对?因为我不知道他所有彩排和预演到什么程度,因为如果说真的是临时可以和她交流的话,其实还是非常震撼的 。

王井东:震撼的意思是说从你的角度来讲,还是不容易嘛。

刘永进:非常不容易,从技术的本身来讲,如果能做到这一点的话,我觉得可能是10年15年以后的技术了,但是不好说,此外说像他们这种演出的资金的投入会非常大,所以他们这种技术应该是 ToB 的、不是 ToC 的,都是全自动的话 ToC 会多一些。就是说用 ToB 的话,可以预先投入大量人力物力去预训练一个模型,所以这里面最后资本推动的力量会有多大,也不是很清晰,对不对?

王井东:从你的观点是不是可以这么去讲,其实这个东西规模化还是比较困难,比如针对一些个别的case,我们可以花很大的精力,比如说江苏卫视花了很多钱对吧?或者说这个公司一直在做相关的技术,然后一直在做邓丽君相关的人像和人体的这么一个重建对吧?

刘永进:我觉得这是黑科技,如果有哪个公司掌握了这种技术,还能花一两个月很快adapt到另外一个演员或者另外一个历史文物,然后在另外一个舞台很快的部署下来,那这个公司肯定是下一个资本会快速增长的,我认为这是一个黑科技,我也很好奇,但是现在我没有机会去看过,真的很憧憬。

王井东:那我们回到技术上面来讲,其实永进老师跟烨斌老师都做了三维的人体重建,包括以前也做过3D相关的东西,因为刚刚谈的人脸,其实刚才这边的demo里面有pose、action等等,从这个意义上技术的挑战以及落地,规模化落地的挑战在什么地方,或者是以后我们要想规模化落地比如 ToC这样的一个应用场景的话,我们能做到什么样的程度?

刘烨斌:这个问题确实是现在比较火的,大家如果关注一些抖音、b站,有一些数字人的直播,他们90%以上都是美工设计的,包括刚才说邓丽君的形象可能也是美工设计,基本都要花几个月时间设计出这样一个IP。然后这个东西还是ToB的,我们学术界当然希望把这个东西做成全自动的,那全自动的一条比较容易的路径是现实的人的avatar,我觉得应该是可以做的,现在的技术也是通过光场多视点采集去采集一些数据,然后去训练一个avatar,包括新动作的生成。当然这个技术现在可能就是数据库里有这样的一个动作,做一个接近的动作是没问题的。但如果说数据库没有翻跟头的动作,生成出来的效果肯定还是不行,而且有时候非常差,但是其实这样也是能够产生一些应用。现在技术越来越轻量化,前端采集可能就需要一个相机或者几个相机去采一些数据,我觉得这个应该是在包括人脸人手以及身体方面,是可以去考虑商业落地的事情。这里面最核心的是动捕的技术,只有动捕重建,把这些做好了之后才能做生成,能生成的比较好。关于刚才智能AI数字人和人去交互这个事情,我觉得确实非常长远。现在的人机对话系统都搞不定。我跟你交流、问你什么问题,你能以接近一个人的智力跟我回答,因为可能问的问题是非常general的,目前人机对话系统一般都还是针对专业领域的,所以这个是比较长远的。

王井东:其他老师有不一样的观点吗?

赫然:实际上落地整个智能生成的话,创作和落地的内容还是相对比较多一点的,但是也有很多的路需要走,比如说现在智能客服营销,自然语言处理里面以前认为是不好解决的,现在实际上很多大公司都上了智能交互的智能客服系统,未来虚拟主播相当于运营的话,百度公司可能会上智能客服,这才是有可能的,因为元宇宙也只收了半身,没收全身对吧,这种情况下还是可以大规模的广泛的应用。然后现在整个的智能生成的话,可能对静态图片的应用比较多,而且基本上都是智能化的,很快就自动化了,比如换脸,人体的图片也是很快的,但是视频的话还是比较难的,因为我们所说的影视剧它都是视频,然后也是一个特别的地方是有近景。可能拉近的情况下看这个人脸,这个时候就是需要另外一种高清的4k传输,那个很多时候换脸就解决不了了,所以说现在特殊场景下静态是可以解决的。

王井东:我沿着大家讨论的,因为刚才赫然老师多次提到3D重建的问题,今天我们6个Topic本身前3个是生成的,后3位老师就是3D相关的,我就抛出这么一个问题就是说有一派说不管这个3D是啥,我只管图像进来,然后得到最后想要的结果,另一类实际上是学习3D的场景的表达,还有传统的比如说geometry。大家看看从这三个角度、三个方向来讲,将来是不是不需要3D的场景,直接可以做,还是我们可能需要3D这个场景。

刘家瑛:从我的视角上,因为可能本身我读书的时候是做Coding的,其实应该是信号处理,然后后来就去做了一些图像处理的东西。现在我觉得我其实蛮同意井东刚刚说的的,可能我觉得现有一些技术的发展,使得有一些以前比如说从2D里面估深度,这在原来信号处理层面上是一个很困难的问题。然后就是最简而言之,原来做图像压缩、信号处理的人很少会接触CVPR或者CV这样的会议,但现在你看其实我在审的paper都是做compression的paper,所以从某种意义上我觉得2D、3D其实这个gap并不大,或者说当然也挺大,但就是说它其实是一个挺合适的一个延伸,所以从我的视角上,也许这几个问题可能在现在有一定量的数据驱动,并且有可能有这种所谓的预训练模型,它里面蕴含的信息会非常的多。然后我记得我曾经跟铁军老师在讨论他们做NLP大模型的时候,因为他知道我做一种艺术设计的东西,他说其实可能因为人的语言的表达非常的丰富,里面蕴含了非常多艺术化的内容,因为唐老师当时举了个例子,他就说可以从里面去学到一些image的分类这些基本的问题,那么其实你可能从大模型里面可以挖掘到一些内容去做艺术化创作,因为我们并没有实际去操作过,但我理解也可能在某一些场景下,因为模型的原因或者数据的原因,使得原来gap比较大的这样的模态或者是研究内容,最终可能会在一套框架下至少是有研究的可能,这就是我的一些想法。

王井东:蛟龙,家瑛说不要3D了,该怎么办。

杨蛟龙:我自己也没有答案,我只是觉得现阶段来讲的话,要真的生成很逼真,然后view consistent,包括temporal consistent,这种高清视频,我个人觉得基于现在的框架可能还是要用3D。起码现在主流的CNN做这个事情不太靠谱。然后现在基于MLP这种影视表达的目标,如果没有新的网络架构出现的话,我觉得3D是必要的,因为ToB上大体还是个黑箱,就是想生成视频,要能保证下一步过来头发丝在哪,这个东西就很难。所以我是坚持数据还是需要的。

王井东:家瑛提到的预训练的概念,实际上预训练的前提是建很大的数据,如果说我们建很大的数据以后,是不是还需要3D的东西。

刘家瑛:也许以后就没有2D,大家都3D了,因为3D的感受其实跟人对自然场景感受是一致的?

赫然:二位老师说的都挺准确的,就是说本身3D作为科学问题的话,是值得研究的,抛开生成之外,本身3D 作为一个问题,重构重建本身就值得研究,而且肯定是个一直要研究的问题。但是如果是说在生成里面到底需不需要3D的话,人也没有精确的建3D的模型,就可以恢复出来脑子里图像的形式,所以说不见得一定要有。现在的一个趋势,尤其是渲染出来之后,如果是在数据量不大的情况下,效果还没有达到真实场景应用的结果。但这个时候可能3D模型的因素就会提高它的生成效果,也有可能像GAN发展过程中,可能前几年会崩,未来几年随着网络结构变成不崩了,但是那个时候可能3D模型就可以弱化。从近两年来看,结合起来是一个大的趋势,至少在很多应用问题上能够缓解一些效果,特别是大角度大姿态,以及细微的变化。但实际上我们刚刚已经说真正难的是人体,车辆和人脸相对比较简单,因为车的话它是方的,人脸的话结构是有限的,比较难的就是人体,人体的姿态变化特别复杂 。另外一个问题就是说人体估计3D会估计的不准,所以刘老师建 了一个500的库,我印象中应该是最大的一个数据库了,所以说3D本身是一个难的问题,把两个难的问题结合起来,也不一定能解决问题。

杨蛟龙:我稍微补充一下,我特别同意赫然老师说的,我觉得人脸还是相对比较简单,人体太难了。这个东西根本感觉没法model一样,所以我觉得刘老师做的一系列工作特别好,然后刘老师刚才说其实建了3万了是吧?

李烨斌:对, 我们暂时发布了500。

杨蛟龙:我觉得能扫描3万个,这个体量相当相当厉害了。

刘烨斌:接着先讲人体,3万个还是只是静态的,现在未来是需要3万个动态的,而且是高精度的才能解决问题,才能再推进一步,所以我觉得下一步应该就是3万个动态的高精度重建的人体,各种动作各种服装,然后才能把人体动作往下推。回到刚刚这个问题,我觉得赫然老师说的非常好,现在看到的元宇宙的一些应用,其实都是很简单的一些3D的geometry,然后贴上一点简单的纹理,这都是20年前的技术,在国外大家好像用的还可以,所以都还是很传统的geometry,接下来应该把geometry做的更好一点,希望能够稍微前进一步。但我觉得如果是纯粹NeRF或者GAN这种图像生成类的,会重建整个工业链,所以还是打破了传统的工业链,需要考虑的事情挺多的。我觉得从技术发展的角度,循序渐进的发展是一个比较合理的趋势。

刘永进:大家都快速的说了一下是2D还是3D,因为我以前是做几何的,我肯定支持3D。但是我觉得各位老师谈的这些问题,可能涉及到好几个层面的issue结合到一起。第一个是解决什么任务,比如说多视角的问题大多会希望是3D,如果说是生成一张以假乱真的图片,我觉得2D就够了。第二个是我们在探讨2D和3D的时候,其实从机理是什么的角度,我了解到87年有一篇心理学的文章,专门探讨人脑当中存的是三维还是二维的。但是我的理解这种研究很多时候依赖具体情况,比如我们要写一篇8页的论文, 拿那么复杂的理论来解决一个基本的问题的话,会被argue,就是说用不着故弄玄虚,用一个那么大的理论来解决一个很实际的问题。有一些很直接的解法,那么为什么不这样去做?因为如果我们去讨论它的机理的话,到底是需要3D还是2D,可能牵扯到多学科交叉,非常复杂。但有时候我们在解决一个具体的工业问题的时候,可能更倾向于找一个简单的解,不一定需要那么fundamental的一些思路,所以很多的因素结合在一起,包括我自己投一些稿子,经常会被审稿人argue说用不着这么复杂,这么复杂建了半天的模型最后也没啥效果,经常被人这么去批评,所以我觉得这是很多层面的问题,都是非常有意义的。

王井东:然后我们留一点时间给现场或者是b站上的观众,大家有什么问题吗?

丁二锐:接着刚才几位老师讲的3D和2D这个事情,从工业界的角度,不管是规模化还是成本都要低。大家觉得从few images里边去恢复甚至是single image里面去恢复一个3D更容易,还是说把摄像头的成本降低,变成刚才刘老师说现在是4个还能恢复的不错,有没有可能就像手机里面只有2个,这两种趋势大家怎么看?哪个会突破,还是说两个会中间握一下手?

刘烨斌:我说一下,我觉得这个要民用可能还是单相机。当然你说 ToB 的肯定还是多相机,然后ToB 也是考虑怎么再简化。最后可能就走到一起去了,当然ToB 端也可能还有很多用武之地,比如搭这种相机阵列、卖相机阵列可能也能养活一些公司,但可能做的不是非常大。我感觉是这样的。

赫然:这是一个很实际的问题,现在手机的大部分卖点就是摄像,然后摄像头越来越多,1个2个3个甚至到4个到5个,也有说背后全是摄像头的,对吧?然后它本身是视觉的问题,不包括在自然语言处理,本来就是和计算、摄像相关的,和硬件是相关的,如果有更好的硬件之后,拍的效果自然就好了,如果有3D相机的话,就不需要用那么多摄像头了,但大多数情况下都是取一个折中,就是手机上的硬件成本和实际的产生效果还是要有一个折中的,现在折中的结果就是3个摄像头,就能把它做得很好,然后很多情况下,我们可以拿手机拍一圈来采集3D信息,未来的话可能这是一个最基本的趋势,尽量用少的摄像头,得到一个好的结果,同时现在软硬件分离没有那么明显了,做的越来越紧密了,很多情况下通过软件来增强硬件的性能,这个时候摄像头自然就可以减少。然后成本的话基本上是在用户可接受的范围之内,我感觉未来趋势的话可能摄像头会越来越少,因为计算能力变得更强了,以前我们手机上有两个摄像头,没有那么高的芯片,仍然是计算不了什么网络。随着网络结构,还有传感器的提高,这个成本应该会逐渐降下来,之后整个的合成的效果还会越来越好。

王亮:我的问题比较多,因为时间关系,你们可以简单的回答一下,第一个问题是问刘偲,你做了视频的背景音乐的配乐,这个工作很重要,但当你演示的时候,我听了几个曲子以后,我都感觉画面和音乐确实是挺和谐的,但是对于几个不同的画面,感觉配乐听起来很相似,我不知道这是不是和你的视频库或者音乐素材库之间有什么样的关系?比如说如果我再换一个场景,是一个嘈杂的菜市场或者是迪厅这样的场景,不知道你会配什么样的背景音乐,这方面能不能解释一下?

刘偲:好的,王老师的问题非常犀利,其实这也是我们下一阶段要解决的一个重点。如您所说,我们现在还是受限于规模较小的数据库,训练出来可能都是比较欢快的音乐。现在能做到的主要是节奏上卡点卡的比较好,比如在转场时音乐的转换,节奏的变化等。但就像您指出的,如果想要生成一些忧伤的或是节奏缓慢的音乐,目前还不太能实现。当时我们开源后很多人也去跑了我们的代码,目前来说生成效果确实还是受限于数据库。我们没有一个很好的data,现有数据集中根本找不到video和music对应的数据,我们当时训练的时候就也只用了音乐单一模态的数据,所以我们也很期待后面能够有机会多多合作。

王亮:我的第二个问题问刘永进老师,现在自然的人机交互是大家一直追求的目标,人机混合智能一直在提倡这个过程,但其实是很难的。包括意图分析、情感分析和自然交互,相信你一直在做这个东西,而且这个问题大家提了很多年,你认为什么样的技术突破了能促进这个领域向前迈一大步,或者说你预测一下,大概多少年以后能够真正的做到那种非常自然的人机交互,像刚才说的智能客服,问着问着就答非所问了这种情况,有没有可能做个预测?

刘永进:我不是专业做人机交互,我们所里面有专业做这个的,我也有一定的了解,因为我也是从共情机理来尝试来切入交互的关系。也就是说智能体如何去反映能够达到自然性,我觉得非常非常难。我举一个例子,包括民用和军用,现在有个专项,成立智能的专家组。把智能划分了几个方面,机器智能、生物智能、群体智能和人机混合智能,那么基本上其他的专家组都有比较明确的去做这个事情。但是人机混合智能,大家做了两年多基本上问不出题目来,大家都觉得人机混合智能跟自己有关系,但是怎么去做,大家其实没有一个很明确的抓手。智能体如何去反应,我觉得可以在一些非常细的点上,比如手机触屏上,输入法上,就在一些很细的点上是有明确的指标性的一些体现,但是通用性的还是很难。我觉得这是一方面,但可能是我现在对于深度强化学习抱有很大的希望。因为它可以自己学习,假设我们有个智能体,它就放在地上,一开始很弱智,它在不停的交互,能从跟人交互的反应知道这个人很烦他,然后能感受到人的情绪状态。比如说视觉或者是一些设备,它能够自己得到一些函数,才能在不断的交互过程当中,能够自己去学习到东西,我觉得这可能是一条路线。它可能形态不一,是六腿机器人或者是播放语音等等,可以有很多的手段,每一个这种他的手段不同。但是如果说将来真的把这些智能体放在我们的环境当中,一开始我们忍受它,跟它长期共存,然后它如果具有自我的强化学习,自己去学习到那些数据,自己有函数,知道这样做人类会有比较的正面的一个反馈。所以强化学习是自己去学一些东西,我觉得这个东西还是很有前途的,比如说转魔方这个例子,人也不知道怎么去转,机器能够通过reward函数进行强化学习。把reward函数设置好,它可以自己学出来。也就是说智能体如何跟我们交互,我们没法设计。当然可以从仿人的行为当中去初步设计,但是可能有些意想不到的事情,会让我觉得很愉快或者很舒适,我觉得这种深度强化学习可能将来会是热点,在我们环境当中如何去跟人智能交互,它可以通过一些实践、探索和大量的失败自我地去学习。这也是比较流行的叫做终身学习或者持续学习。我觉得这是个愿景,因为我们需要大量的场景,可能要布置智能体到比如说幼儿园有长期数据的收集,这个只是我的一个想法,也没有去尝试过。

王亮:我还有最后一个问题,因为今天的主题是智能内容创作,创作里面可能就牵扯到一个评价问题,刚才家瑛也提到了,这个评价问题是很难的。比如刘偲做的工作在镜头切换的时候,音乐听起来是不是很突兀?创作的诗词是不是符合人的逻辑和理解?美妆变脸以后画风是不是符合美感?其实有很多问题。所以说在咱们这个领域,除了人去观察或者人去听,有没有可能会产生一种客观的评价体系,比如某些方向提出了所谓自评估的概念。这种自评估能不能加入到咱们这种内容创作的评估和优化中来,就是每次根据模型自动的评估它的一些指标,然后不断的优化,让这个指标会更好,有没有这种可能性,大家可以做一个预判或者是分析一下。这个任何人回答都可以。

刘家瑛:我前两天刚审了一篇paper是做UGC的内容评价应该是很热的研究问题,但是这里面目前看到的方法,王老师刚才提的想法还挺新的,我感觉我目前看到的工作多半还是去从两个视角,因为我可能主要做围绕基本图像视频层面上,跟交互比较少,可能有三方面吧,第一个可能从单纯的本身的质量上去评估它,然后当然评价指标可能是有一些从特征层面或者是像素层面的衡量的一些单元。然后第二个可能会考虑到跟人有一些交互,就是人可能不需要很复杂的共情,只是简单的说prefer不prefer或者在这个阶段上我可能希望它停下来,就是有一定的人机交互的层次参与在UGC创作里面。第三点是可以拿客观指标,就说生成了一张人脸除了好看之外、一些性能是不是ok,那问题是怎么把这几个不同的维度修正在一起,其实也是一个比较困难的话题。像您刚刚提出的用一个网络去学习这些features,我觉得也是现实的,但是它依旧还是规避不掉到底网络去用什么样的指标作为一个lose或者是怎么样去衡量他们之间的reward,然后再去更新他的评价的指标。

刘永进:我觉得用户评估目前来看是无可颠覆的,因为在心理学当中的量表,有5点量表或者7点量表或者10点量表,你跟心理学的人去沟通的话,会发现量表最终的评价手段,用户评估是无可避免的,否则心理学专业要撤掉了,就是没有太多他们的事情。所以我觉得很多评估网络是通过搜集用户的数据,训练出来的评估网络 ,然后因为让用户填量表、搜集问卷是一件非常繁琐的事情,成本很高,但是这个是最终的一个手段验证对还是不对。可以通过前期的搜集量表去训练和评估网络,那么后面在具体设计模型算法的时候不需要太复杂的过程,所以基本上我认为目前的实验方式是这样的,但是我还是认为用户评估不可颠覆,至少我觉得智能体没有强大到这个程度。

王井东:我们给线上的观众一个机会,有观众提了这么一个问题,其实跟我刚才提的问题多多少少有点相似,但是把这个问题具体化一下,各位老师们觉得AI驱动虚拟人需要多久才能达到现在的真人驱动虚拟人,类似刚才邓丽君的例子,大家觉得需要多久或者说技术上还要走哪些路?

刘烨斌:我觉得15年以上。

刘家瑛:我没有看过邓丽君的演示,但我自己前段时间带小孩去环球影城,玩过哈利波特禁忌之旅,其实那个里面应该是一种VR的体验,感受还挺好的,因为当时可能乘坐的设备比较急速,然后那种感受,包括他对小孩子的冲击力,我觉得整体上的感受其实还是不错,但是前期投入肯定也是一样的。我猜都是属于那种前期投入比较多,所以我理解要看什么样的应用场景,如果是那种特殊的,然后精心打造的,这种可能应该是感受不错的,但是可能希望能够大规模的应用,能够比较切实的这种,比如说在交互,电话会议、上课或者什么之类的,对目前这种技术可能要求比较高。

杨蛟龙:我觉得其实近几年如果真的想把虚拟人抓的特别精细,没有什么太多的进展,或许我同意刘永进老师的,十到十五年吧。

王井东:然后时间也差不多了,最后我想请每位老师,就自己的研究方向或者相关的研究方向,谈一谈将来1年、3年、5年的展望。

刘家瑛:因为我们组围绕艺术创作的同学比较多,其实学生本身比较擅长做相关的一些,比如本身比较擅长画画或者拍照等等,有一些有艺术技巧的小伙伴。所以从我内心的话,我还是觉得希望能够利用智能技术做一些这种艺术创作的工作。此外还希望能够去反映一些某种意义上的情绪,人的情绪表达能够蕴含在其中。我觉得这个内容的话,其实我18年来百度就提过这个议题,同样还是我今天秀的艺术化的文字,但是其实文字是有语义的,如果我们能够有一天可以直接根据某些文字做艺术化的创作,并且还能够表达到这个语义层面,我觉得这其实可能某种意义上也是会带来更好的一些研究的视角。

王井东:家瑛老师这个主要是语义层面上的。

赫然:实际上人工智能近几年特别火,主要原因还是有很多的技术能够落地,然后在语言语音上都有很多的技术落地,如果到视觉的话,我觉得可能下一个能落地或者体验的点还是内容的生成。可能是未来学术界和企业界更关注的一个比较前沿的点,同时在国家战略方面也是很重要的一点,比如说人工智能隐私和智能创作也是直接相关的,所以我个人感觉这个方向也是一个很前沿的方向,值得我们做的方向。

刘烨斌:我的愿景就是PPT讲的那几个,一个是沉浸式的视频会议,蛟龙做的也很好。然后我们也希望在这个方向继续推进。应该在这一块确实受限于显示终端的性能,我们希望能做到更加简便的采集、实时、高真实感。第二个就是数字人,可能5年内数字人应该是受控制的,这种数字人就是我驱动它,由第三方驱动,产生一个非常真实感的数字人。我觉得这个应该是未来5年内的目标。第三个是AI的方法,AI数字人就是结合跨模态多学科和人工智能包括情感的一些技术,我觉得可能还需要更长的时间。

刘永进:我现在特别推崇赫然老师说的落地应用,我觉得最近大家对于人工智能的热衷,大量的人员参与其中都是因为落地应用。对于整个社会的普及,大量的年轻人进入到这个行业,从而把这个行业推动的更好,非常有价值。如果只有几个人在其中研究的话力量不够,我觉得是两方面都需要,一方面就是在高校做的还是不错的,有一个15年的目标,做到退休为止,这个是一个比较长远的目标。但是对于近一两年的话,我也是非常希望能够做到落地应用,我个人理解的落地应用就是每当一项技术做到85%,90%的时候,技术是在发挥主要作用,但是最后从90%到100%的时候,工作量会特别特别的大,但是有时候放到工业上一些P图或者一些这种定制化的设计,帮一些工业人员去做一些巧妙的设计,就可以把这个问题回避掉,所以这是很好的一个落地应用的途径,就是不要尝试在工业落地上去解决100%的这种技术的问题。最近很多虚拟数字人的应用,很多工作是跟UI在一起设计,把这个场景设计的非常好,从而回避掉了这些难点,比如说虚拟主播只有手没有腿,但是我们感受不到,因为那个场景是没有腿在运动的。我看很多的应用都是UI的设计、工业工程或者美术学院人员在推导,中间可能用到的一些智能的技术,去体验一下智能的水平,我觉得这是目前很好的一个合作的方法,包括华为的河图,和敦煌合作的九色鹿,其实它也不是100%解决所有的问题,但是把设计做得非常好。所以我也觉得要从事这方面的落地应用,也想找到这样的场景。在技术上可能不会说一下子解决所有的问题,所以我还是希望更多的人来参与到热潮当中,让人工智能发挥作用,包括虚拟内容的生成能够越来越兴旺。

王井东:我能不能理解一下永进老师的观点,就是说咱们做技术的要务实一点,能用一些UI相关的东西去做最后一小步,能不能这么讲?

刘永进:不能太技术,你跟美术学院的聊,他觉得你不要跟我讲技术,就是不能为了技术而技术。

刘偲:我这边的未来工作主要是三个方面:首先是跨模态,不局限于编辑图像,我们会考虑结合音频和文本。比如给一段语言描述就可以修改图像,我还是比较感兴趣的。其二,我想吃一吃大模型、大数据的红利。现在能看到融合大模型去做图像编辑的确会有更好的效果,但依然存在很多挑战,比如没有足够的数据,或是从互联网上下载的数据中存在很多噪声,或者下载下来的图文存在不匹配的问题,再有可能有些时候文本的语义层面明显高于图像。好比一张猫的图片,文本对应的是“猫咪能有什么坏心眼”,就不属于统一的语义层面。所以如何利用大数据、大模型来做图像编辑,这是我们重点关注的第二点。第三点是结合我现在做的音乐相关的工作,因为我以前没有这方面的基础,所以最近恶补了很多乐理知识。组会的时候,同学们都拿着琴来教我要怎么弹,所以如何把knowledge嵌到网络中,其实也挺难的。因为不管是作诗还是作曲,其实都有套路,但如果纯数据驱动的去学其实也比较难。所以主要就是这三点,跨模态、大模型,还有就是知识嵌入。

王井东:其实前两点,我们今天应该去展开讨论的,但是由于时间关系,我想讲一讲最后一个,因为你讲的第三点实际上是把knowledge嵌在里面。第二点实际上是大数据。往往我们利用大数据的时候,是减少knowledge的依赖,我不知道你怎么看待这件事情。

刘偲:做音乐生成任务的,其实还有一个好像是Google的工作,效果还是挺好的,它没有显式的嵌入knowledge,但也会有一些反复之类的套路,确实是隐式的encoding进去了。我们现在也还在探索,看能不能显式的加进去,这些工作还在进行当中。

王井东:好,期待你的工作。

杨蛟龙:我的研究方向的话就是关于3D的生成和编辑控制了。我个人的愿景是两方面。一个是对一个虚拟人的控制,当然我个人对卡通形象不是特别感兴趣的,所以还是一个真实的虚拟人的控制。这里面我认为最大的难点还是动捕,尤其是精细的动捕 ,把所有的精细的细节提取出来,我认为近几年都没有什么进展,以后如果把这个问题往前推进了,5年10年内把这个问题解决了,比如以后生成一个虚拟助理,这个很关键。没有那些细节,体会不到共情。另外一方面还是我本人,但是我要实时地做一个视角合成。我觉得还是从质量、实时性,然后还有就是摄像头尽量要少,越来越便捷。因为不可能所有人都买几个摄像头,像我们设备其实很便宜的,但是还是越少越好。如果将来真的是拿一个手机两个摄像头,有很好的外插能力, 或者是拿一个大家直播的杆,然后两边放两个,就这样够了,然后别人就可以任意跟你去聊天,像你在前面一样。这是将来的5到10年内我们要推的,我们应该都会朝着两方面去努力,谢谢。

王井东:好,谢谢6位老师的精彩分享,谢谢线上线下的观众一直坚持了将近5个小时,今天咱们视界无限的活动就到此结束,谢谢大家。

推荐内容

More >>>- · 第八十三期CCF-CV走进高校系列报告会于悉尼大学圆满结束

- · 第八十四期CCF-CV走进高校系列报告会于广东石油化工学院圆满结束

- · 第七十三期CCF-CV走进高校系列报告会于苏州科技大学圆满结束

- · 第七十四期CCF-CV走进高校系列报告会于河北大学圆满结束

- · 第七十期CCF-CV走进高校系列报告会于太原理工大学圆满结束

- · 第六十八期CCF-CV走进高校系列报告会于北京信息科技大学圆满结束

- · 第三届计算机视觉及应用创新论坛在广州举办

- · 第一届中国模式识别与计算机视觉大会在广州召开

- · CCF-CV专委会2018年度全体委员会议在广州成功举办

- · 【预告】CCF-CV走进高校系列报告会(第五十八期,广西师范学院)