【论文导读】2024年论文导读第六期

论文导读

2024年论文导读第六期(总第九十七期)

目 录

1 | Autoencoder-based Collaborative Attention GAN for Multi-modal Image Synthesis |

2 | Cross-Receptive Focused Inference Network for Lightweight Image Super-Resolution |

3 | VGOS: Voxel Grid Optimization for View Synthesis from Sparse Inputs |

4 | Noise Imitation Based Adversarial Training for Robust Multimodal Sentiment Analysis |

5 | Prototypical Bidirectional Adaptation and Learning for Cross-Domain Semantic Segmentation |

6 | Low-Light Enhancement Method Based on a Retinex Model for Structure Preservation |

01

Autoencoder-based Collaborative Attention GAN for Multi-modal Image Synthesis

作者:曹兵,曹海芳,刘家旭,朱鹏飞,张长青,胡清华

单位:天津大学智能与计算学部

邮箱:

caobing@tju.edu.cn, caohaifang@tju.edu.cn, realliujiaxu@tju.edu.cn, zhupengfei@tju.edu.cn, zhangchangqing@tju.edu.cn, huqinghua@tju.edu.cn

论文:

https://ieeexplore.ieee.org/abstract/document/10124026

代码:

https://github.com/caohaifang123/ACA-GAN

摘要:

从临床诊断到公共安全,多模态图像已广泛应用于各种实际场景。然而,由于成像条件的限制,某些模态可能不完整或不可用,这通常会导致在许多实际应用中出现决策偏差。尽管现有图像生成技术取得了重要进展,但从多模态输入中学习互补信息仍然具有挑战性。为了解决这一问题,本文提出了一个基于自编码器的协同注意力生成对抗网络(ACA-GAN),通过可用的多模态图像来生成缺失图像。协同注意力机制分为单模态注意力模块和多模态注意力模块,有效地从多个可用模态中提取互补信息。考虑到显著的模态差异,我们进一步应用自编码器网络来提取目标模态的自表示,引导生成模型学习融合来自多个模态特定于目标模态的信息,提高了与目标模态的隐空间一致性,从而增强了图像合成性能。

方法:

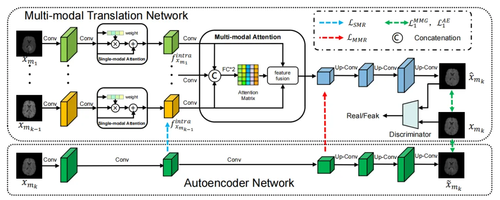

图1 ACA-GAN整体框架

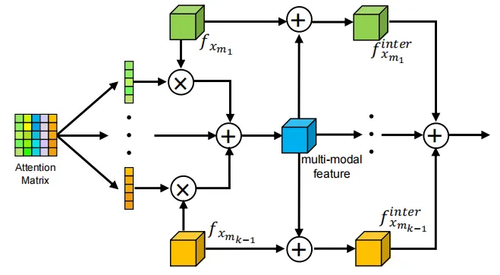

本文所提框架如图1所示,由多模态翻译网络和自编码器网络组成。为了融合特定于所需模态的多模态表示,我们首先设计了一个多模态注意力模块,从不同的输入模态中提取目标模态特定的多模态特征表示。具体地,首先将来自多个输入模态的特征连接起来,并将它们输入到全连接层中,以获得注意力矩阵A,然后使用该矩阵通过channel-wise乘法对特征进行加权。通过组合这些特征生成多模态特征,然后将其添加到每个输入特征中以生成特定模态的特征。最终的多模态融合特征通过融合模态特定特征生成。我们在图2中给出了多模态注意力特征融合的详细架构。

图2 特征融合架构

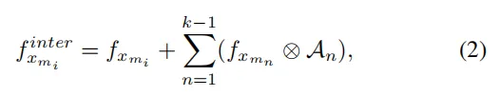

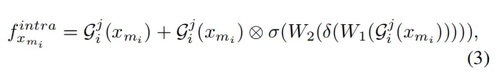

公式(1)和(2)分别为注意力矩阵与特定模态的特征计算。

由于多模态注意力模块通过融合多模态互补信息来提高多模态图像合成的性能,所以每个模态都应该向该模块提供足够的兼容信息。考虑到注意机制在学习特定信息方面的优势,进一步引入单模态注意力模块,在每个编码器分支中提取更多兼容特征。

为了生成具有精确结构和逼真细节的特定模态图像,合成图像必须在图像级和特征级上与目标图像一致。考虑到自编码器已被证明在编码自表示特征方面的有效性,引入自编码器网络强大的自表示能力来引导多模态协同注意力学习,为多模态合成网络提供逐层特征监督。

实验:

我们在两个具有挑战性的多模态场景中验证了我们提出的ACA-GAN框架的有效性:医学图像合成(BraTS2020)和光照图像合成(Multi-PIE)任务,此外,我们还进行了面部表情合成的实验(RaFD)。

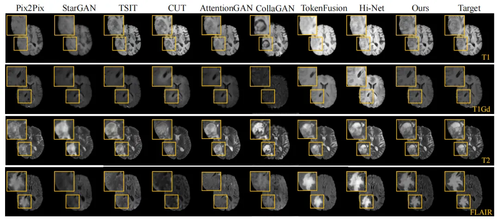

图3 医学图像合成定性比较

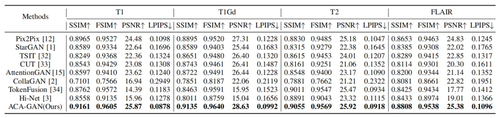

表1 医学图像合成定量比较

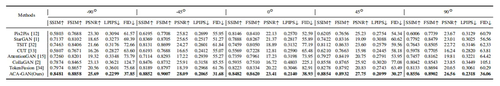

图4 光照图像合成定性比较

表2 光照图像合成定量比较

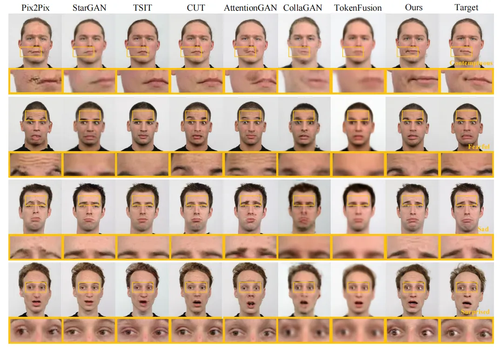

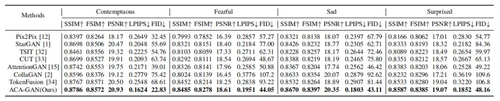

图5 面部表情合成定性比较

表3 面部表情合成定量比较

通过上述三个数据集上的定性与定量比较,可以发现我们的ACA-GAN在与竞争方法的比较中都能取得较好的结果,进一步体现了我们方法对多模态信息的提取和融合能力。

总结:

本文提出了一种基于自编码器的协同注意力生成对抗网络,用于多模态图像合成。利用单模态注意力学习兼容信息,利用多模态注意力从多模态输入图像中提取互补信息。通过引入自编码器网络,为多模态翻译网络提供跨模态一致性指导。多分支编码器和模态掩码向量使我们的ACA-GAN能够在单个统一模型中生成任何缺失的模态,从而进一步保证了其泛化性。通过在三个数据集上的实验验证了我们所提出的协同注意力生成网络的优异性能。

02

Cross-Receptive Focused Inference Network for Lightweight Image Super-Resolution

作者:李文杰1,李俊诚2,高广谓1*,邓伟洪3,周建涛4,杨健5,齐国君6

单位:1南京邮电大学 2上海大学 3北京邮电大学 4澳门大学 5南京理工大学 6西湖大学

邮箱:

lewj2408@gmail.com;

cvjunchengli@gmail.com;

csggao@gmail.com

论文:

https://ieeexplore.ieee.org/document/10114600

代码:

https://github.com/IVIPLab/CFIN

*通讯作者

1. 简介

最近,基于Transformer的方法单图像超分辨率(SISR)任务中表现出令人印象深刻的性能。然而,需要结合上下文信息来动态提取特征的变换器功能却被忽视了。

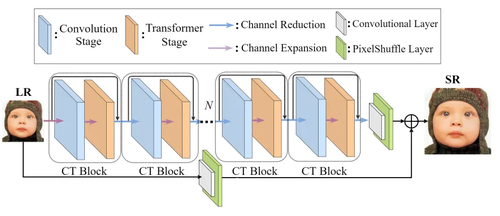

为解决这一问题,我们提出了一个用于轻量级SISR的交叉感受野聚焦推理网络(CFIN),由一系列混合CNN和Transformer的CT块级联构成。具体来说,在 CT 块中,我们首先提出了基于 CNN 的跨尺度信息聚合模块(CIAM),使模型能更好地关注潜在的局部有用信息,以提高变压器阶段的效率。然后,我们设计了一种新颖的交叉感受野引导Transformer(CFGT),通过使用一个调制的理解当前语义信息的卷积核,并利用不同的自注意力中的信息交互,从而实现了对重建所需的上下文信息的选择。大量实验证明,我们提出的CFIN能够有效地利用上下文信息重建图像,并且作为一种高效的模型,它能够在计算成本和模型性能之间取得良好的平衡。

2. 方法

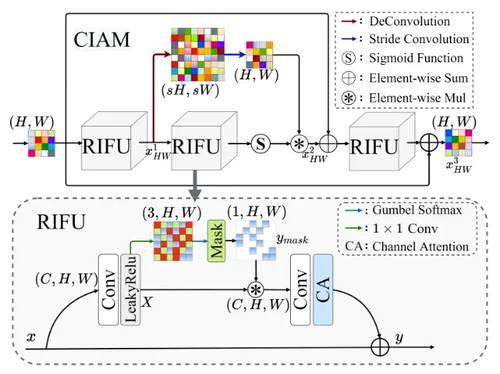

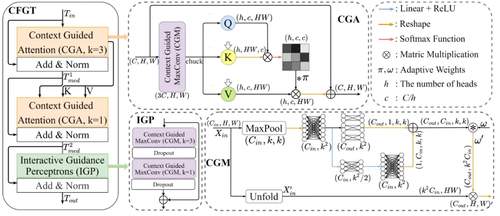

方法的整体结构如图1所示,它由一系列级联的卷积模块(我们的跨尺度信息聚合模块CIAM)和Transformer模块(我们的跨感受野引导Transformer CFGT)构成。如图2所示,CIAM精心组合了多个用于去除冗余信息并灵活学习局部特征的冗余信息过滤单元(RIFU),以确保充分利用有用的局部特征。如图3所示,在CFGT中,我们提出了一种上下文引导注意力(CGA)方案、它可以自适应地调整调制卷积核的权重,以实现对所需上下文信息的选择。此外, CFGT通过进一步结合不同感受野的 CGA,以进一步促进上下文互动。值得注意的是,图像中的每个像素都不可能是孤立的,它们应该与周围的像素有一定的关系,这种关系在文中被称为上下文信息。

图1 我们提出的跨尺度聚焦推理网络(CFIN)的整体架构。

图2 我们提出的跨尺度信息聚合模块(CIAM)和冗余信息过滤单元(RIFU)。

图3 我们提出的跨感受野引导Transformer(CFGT)、上下文引导注意力(CGA)、上下文引导的 MaxConv (CGM) 和交互式引导感知器 (IGP)。

3.实验分析

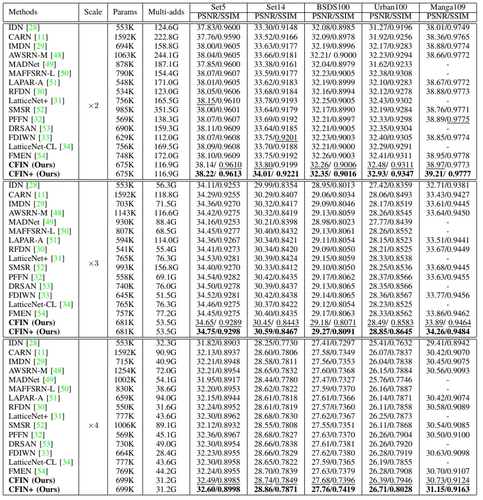

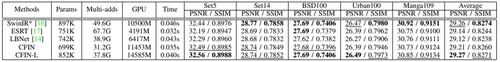

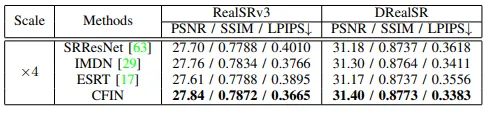

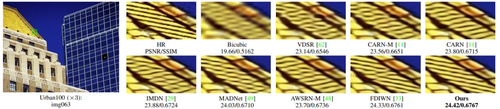

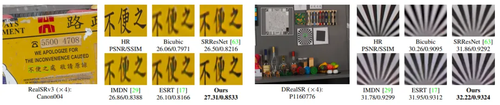

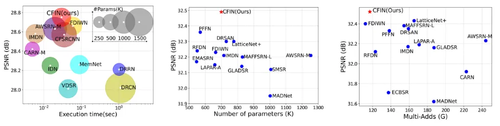

本方法在DIV2K训练集上训练,在Set5, Set14, BSDS100, Urban10, Manga109这5个主流合成测试集上进行实验,表1和表2提供了与先进方法的定量比较,图4提供了在BSDS100测试集上的视觉比较。此外,表3还提供了真实世界超分辨率数据集RealSR和DRealSR的结果,图5提供了相应的视觉比较。为了比较各个方法的效率,我们还在图6验证了我们的方法与其他先进方法在模型大小,推理速度以及性能上的综合权衡。看以看出,我们的方法在所有测试集上都取得了最佳表现,并且在模型效率的权衡上也有均衡的表现。通过广泛的实验可以证明,我们的CFIN 通过巧妙地整合了 CNN 和 Transformer,在计算成本和模型性能之间实现了良好的平衡。

表1 与其它先进基于CNN的SISR 模型的性能比较。最佳和次佳结果分别以高亮度和下划线表示。“+”表示模型使用了自集成策略。

表2 与一些基于变换器的 ×4 SR 方法的比较。* 表示该模型是在 ×2设置下进行了预训练,训练补丁大小为 64 × 64(我们的训练补丁大小为 48 × 48,没有经过预训练)。CFIN-L 表示我们的更大的版本。

表3 真实世界数据集的定量比较。

图4 在BSDS100测试集的视觉比较

图5 在真实测试集RealSRv3和DRealSR的视觉比较

图6 方法的效率权衡

03

VGOS: Voxel Grid Optimization for View Synthesis from Sparse Inputs

VGOS:用于稀疏输入视图合成的体素网格优化

作者:孙嘉锴、张占杰、陈嘉芙、李光远、吉柏言、赵磊*,邢卫*

单位:浙江大学计算机学院

邮箱:

cszhl@zju.edu.cn

论文:

https://www.ijcai.org/proceedings/2023/0157.pdf

代码:

https://sjojok.github.io/3dgstream

*通讯作者

在三维视觉领域中,新视图合成是一项具有挑战性的任务,旨在从给定的源图像及其相机姿态中合成具有任意目标相机姿态的目标图像。最近,神经辐射场(NeRF),一种基于学习的神经隐式表示,能够产生高质量的新视图合成结果。然而,NeRF需要几十到几百个密集的输入和数小时到数天的训练时间才能获得高质量的结果。当考虑到自动驾驶、AR/VR和机器人等缺乏密集数据并需要实时性能的现实世界应用时,NeRF依赖密集输入视图和漫长优化时间的局限性被进一步放大。尽管使用体素网格来表示辐射场可以显著加快优化过程,但我们观察到,对于稀疏输入,体素网格更容易过度拟合训练视图,并且会有洞和浮动,从而导致伪影。

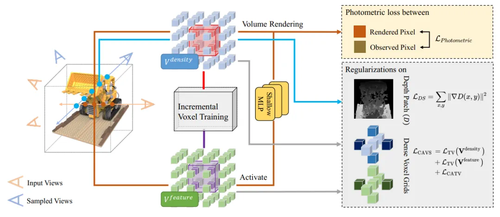

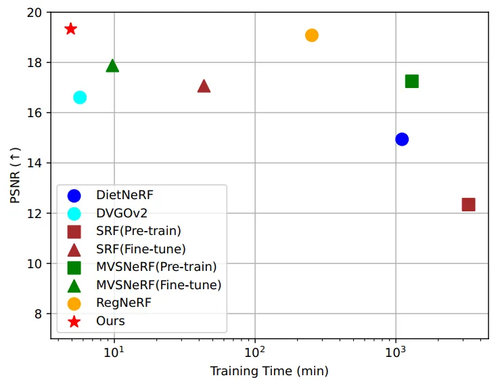

为了解决上述问题,我们提出了一种从稀疏输入(3-10视图)快速(3-5分钟)重建辐射场的方法,即VGOS,如图1所示。为了提高基于体素的辐射场在稀疏输入场景中的性能,我们提出了两种策略:(a)引入了一种增量体素训练策略,该策略通过在重建的早期抑制外围体素的优化来防止过拟合。尽管DVGO使用各种技术来避免退化解,但对于稀疏场景,辐射场将过度拟合到输入视图。具体而言,对于稀疏输入,在训练的初始阶段,靠近相机近平面的外围体素具有高密度值,以再现输入视图。然而,外部体素的高密度值阻碍了内部体素的优化,这使得辐射场难以收敛到正确的几何结构,从而导致新视图下的渲染结果的质量下降。增量体素训练策略不是优化全部的体素,而是只优化内部的体素,冻结了外围体素的优化,避免了过拟合。(b) 使用了几种正则化技术来平滑体素,从而避免了退化解。我们提出了一种新的稠密体素网格上的颜色感知体素平滑度损失,并在采样视图上利用深度平滑度损失来平滑体素。在辐射场中,在颜色急剧变化的地方,密度变化并不平滑。根据以上观察,提出了颜色感知总方差损失,它使用颜色体素网格中的激活值来引导密度体素网格的平滑损失。几何的分段光滑是深度和视差估计中的经典假设,因此我们在未被观察的视角上引入了深度平滑度损失来改善场景几何。实验表明,VGOS在没有任何预先训练的模型和只以RGB图像作为输入的情况下,以超快的收敛性在稀疏输入方面实现了最先进的性能,如图2和图3所示。

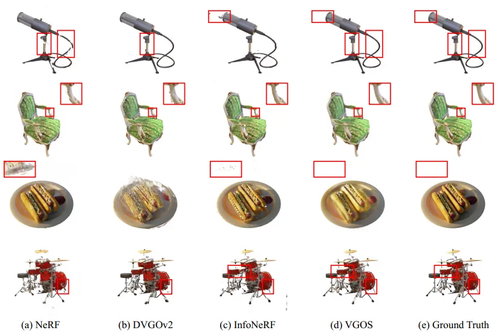

图1 VGOS体系结构概述。除了来自给定的一组输入图像(橙色视角)的光度损失之外,深度平滑度损失被施加在来自采样视图(蓝色视角)的渲染深度图像块上,并且体素网格通过所提出的颜色感知体素平滑度损失而正则化。此外,通过增量扩展优化体素(红色和紫色体素)的范围,使用增量体素训练策略来防止过拟合。

图2 在3张图像的稀疏输入条件下,在LLFF数据集上VGOS和现有方法之间的比较。注:为了进行公平的比较,每种方法的训练时间都是在单个NVIDIA RTX 3090 GPU使用各自的官方实现来测量的。对于稀疏输入,提出的模型在重建速度(训练时间)和结果质量(PSNR)方面都优于以前的方法。

图3 在四张图像的稀疏输入条件下,对真实合成360°进行定性比较。所有实验都是用相同的输入进行的。

04

Noise Imitation Based Adversarial Training for Robust Multimodal Sentiment Analysis

作者:袁子麒1,刘一贺1,2,徐华1,高凯2

单位:1清华大学,2河北科技大学

邮箱:

yzq21@mails.tsinghua.edu.cn

512796310@qq.com

xuhua@tsinghua.edu.cn

gaokai@hebust.edu.cn

论文:

https://ieeexplore.ieee.org/abstract/document/10103636

代码:

https://github.com/Columbine21/NIAT

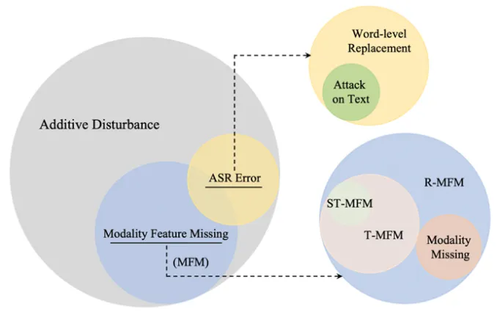

作为现实世界应用中不可避免的现象,环境噪声已经成为多模态情感分析面临的最重要挑战之一。然而,现有方法仅关注模型在特定噪声类型下的鲁棒性。在现实场景中,由于同时存在多种类型的噪音,针对特定噪声类型训练的模型往往表现不佳。为了能够真正提升模型在真实应用中的鲁棒性,我们首先对常见的噪声类型进行了分类,如下图

图1 环境噪声的层次化分类体系。

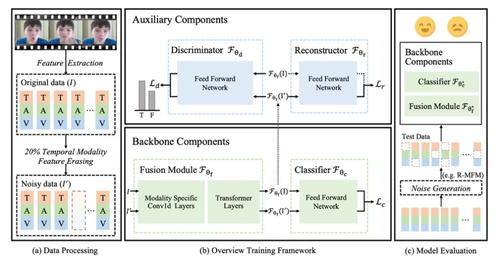

在方法层面,本文在抽取的模态特征序列上建模,并提出基于噪声模拟的对抗训练框架,以提高对推理期间各种潜在不完整性的鲁棒性。具体而言,所提出的方法首先使用模态特征擦构建含有噪声的增强样本,并通过自注意机制利用模态交互来学习原始-加噪实例对的多模态表示。然后,基于成对的中间表示,提出了一种新颖的带有语义重建监督的对抗训练策略,以学习嘈杂和完美数据之间的统一联合表示。

图2 基于噪声模拟的对抗表示学习框架

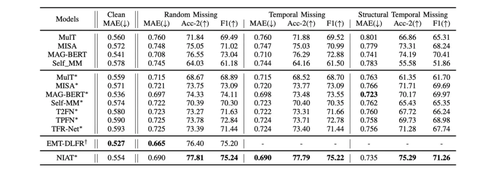

在实验中,我们首先验证了所提方法在模态特征缺失的情况下的有效性,展示了令人印象深刻的性能。此外,我们还展示了我们的方法在其他类型的不完整性方面取得了出色的结果,包括模态缺失、自动语音识别错误和文本攻击,突显了我们模型的泛化能力。

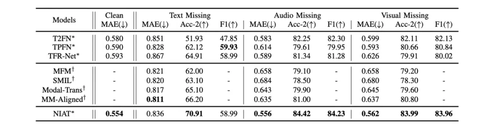

表1 MOSEI数据集上,模型性能在三种特征缺失下的对比结果。

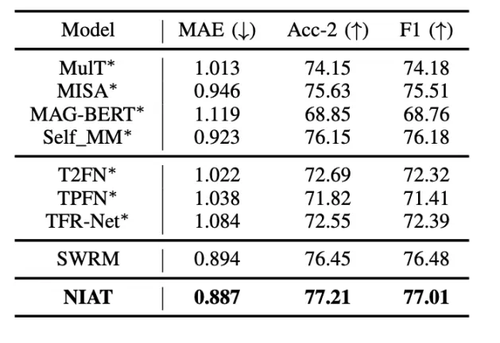

表2 MOSEI数据集上,模型性能在三种模态完全缺失下的对比结果。

表3 MOSI数据集中,在ASR识别错误扰动下,模型性能对比

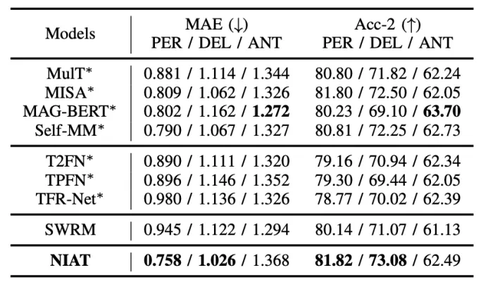

表4 MOSI数据集中,在文本攻击场景下,模型性能对比

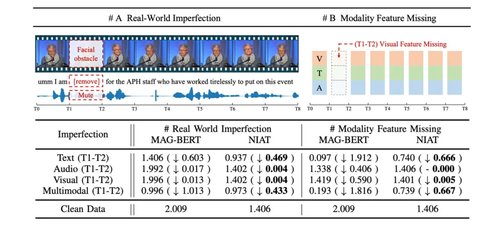

最后,我们进行了关于一般性加性环境扰动的案例研究,介绍了将背景噪声和模糊引入原始视频剪辑中,进一步展示了我们所提方法在现实应用中的能力。

表5 使用特征层扰动建模一般性加法环境扰动的案例分析

本项工作是针对多种类型特征扰动,构建和评估统一模型的首次尝试,针对各种异构的不完整性,包括模态特征缺失、整个模态缺失、自动语音识别错误和文本模态攻击。此外,该工作进一步强调了理想化特征层的噪声与现实世界环境扰动间的潜在差异。我们相信,本文将吸引研究人员设计强大的方法,评估提出方法对各种潜在数据噪声的鲁棒性,并进一步探索如何模拟、建模现实世界中环境扰动的基本问题。

05

Prototypical Bidirectional Adaptation and Learning for Cross-Domain Semantic Segmentation

作者:任庆桦1,毛启容1,Shijian Lu2

单位:1江苏大学,2南洋理工大学

邮箱:

qinghua.ren@ujs.edu.cn

论文:

https://ieeexplore.ieee.org/document/10102322

代码:

https://github.com/renqinghuaha/PBAL_TMM2023

1. 研究背景

近年来,深度学习方法已在图像语义分割领域取得了巨大进展,这在很大程度上得益于大量的像素级标注数据用于训练模型。然而,逐像素人工标注过程通常费时费力且成本高昂,加之领域偏移现象的存在,这都限制了其在现实应用范围内的推广和应用。为了克服对人工标签的依赖限制,跨域语义分割旨在解决从标记源域到未标记目标域的分布变化问题。最近的研究表明,原型学习方法在跨域语义分割任务中表现优异。然而,现有的工作尚未深入探讨源域原型特征与目标域特征之间关联关系的构建方式,同时也未考虑到在伪标签学习阶段对输出空间与特征空间进行联合优化的问题。因此,本文提出了一种面向跨域语义分割的双向原型学习与原型自训练方法,旨在更有效地学习鲁棒的域不变性特征。

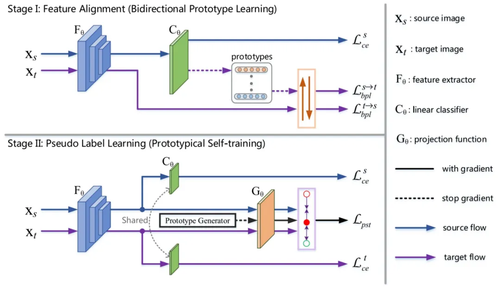

2. 方法概述

本文聚焦于特征对齐与伪标签学习两个方面,通过阶段式的训练方式来解决域适应问题,其方法主要分为两个部分:

I. 基于双向原型学习的特征对齐方法:利用类别原型特征来刻画源域的语义知识,鉴于源域与目标域的内在联系是共同语义知识,本文设计了两条互补的双向自适应路径,更有效地建模了源域原型特征与目标域特征之间的关联关系,从而在潜特征空间实现跨域特征更充分的对齐。

II. 原型特征引导的自训练策略:考虑到传统的伪标签学习方法缺少对跨域特征空间进行显式的优化,本文利用了原型对比学习来更充分地加强同类别特征的关联,并利用了类别感知的加权策略以促进稀有类别的学习,从而在自训练阶段实现了对输出空间与特征空间的联合约束。

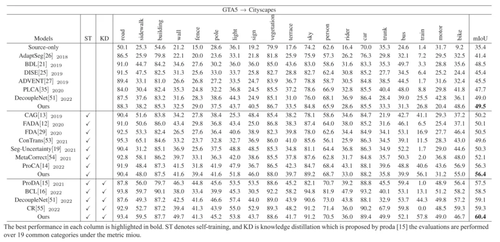

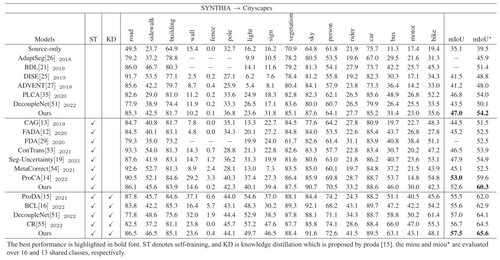

3. 实验结果

本文在两个公开的跨域语义分割数据集上进行实验,其结果表明了所提出的方法优于现有方法。

06

Low-Light Enhancement Method Based on a Retinex Model for Structure Preservation

基于Retinex模型的结构保持的低光照图像增强方法

作者:周明亮1,邬兴泰1,魏雪凯1,向涛1,房斌1,Sam Kwong 2

单位:1重庆大学,2香港城市大学

邮箱:

mingliangzhou@cqu.edu.cn

450924536@qq.com

xuekaiwei2-c@my.cityu.edu.hk

txiang@cqu.edu.cn

fb@cqu.edu.cn

cssamk@cityu.edu.hk

论文:

https://ieeexplore.ieee.org/document/10106032

代码:

https://github.com/bbxavi/spcv22

低光图像增强对于计算机视觉系统至关重要。低光照环境下捕获的图像由于光线的不足,往往表现出较低的对比度和清晰度,使得细节难以辨认,同时伴随着噪声的显著增加,图像结构的失真,进一步影响了图像的信息量和视觉线索。这些问题还严重影响了后续计算机高级视觉任务的处理与应用。如何解决低光照环境导致的图像边缘、轮廓等结构特征模糊不清是一个亟待解决的问题。目前基于Retinex理论的低光增强方法忽视了低光图像的结构失真问题,导致增强的图像视觉效果提升但损失了结构信息,无法为下游的机器视觉任务提供有效的视觉线索。因此,设计一种结构保留的低光图像增强方法是当前研究的重要方向之一。

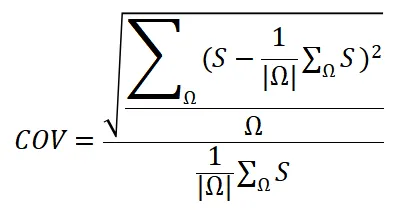

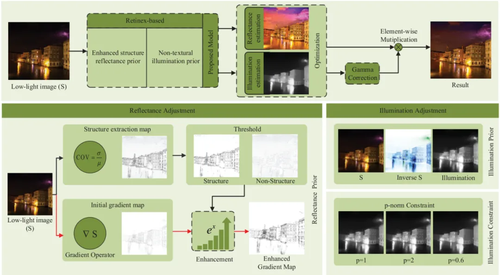

针对上述问题,如图1所示,本文通过使用变异系数(COV)提取图像的结构先验信息并利用Lp范数调整光照层。COV通过计算标准差与平均值的比率来量化数据的离散程度,其公式如下所示:

其中,Ω为一个局部3×3的像素区域,S是低光图像。在低光照图像增强任务中,COV被用来识别低光照图像中结构较为显著的区域。具体地,我们对图像的局部3×3像素区域进行分析,通过COV的计算来区分图像中的结构和非结构部分。这对于在增强过程中保持图像的结构完整性至关重要。COV的引入有效的提取出图像中的边缘、轮廓等重要细节,从而在增强过程中针对性地保留这些关键信息,为后续的图像分析和理解打下了坚实的基础。

此外,我们还引入了“逆暗通道先验”来生成光照的初始估计。这种方法模拟了图像在有雾条件下的视觉效应。通过这种方式,我们能够获得一个符合实际光照条件的估计,为后续的光照调整提供了一个合理的初始值。为了进一步优化光照层,我们通过引入Lp范数调整估计光照的平滑性,避免在增强后的图像中出现不自然的光斑或过曝区域,确保了光照层与反射层之间的一致性。

图1 我们的方法框架图

本文的主要贡献如下:1)通过引入变异系数(COV),用于提取低光图像的结构层,以获得精细的反射率先验。2)通过结合COV和Lp范数约束设计能量函数,使增强的图像有较好的结构保持效果,而光照层可以获得更好的非纹理信息。3)根据广泛的实验,与其他最先进的方法相比,我们提出的方法在主观和客观评估指标方面都能取得优异的效果。

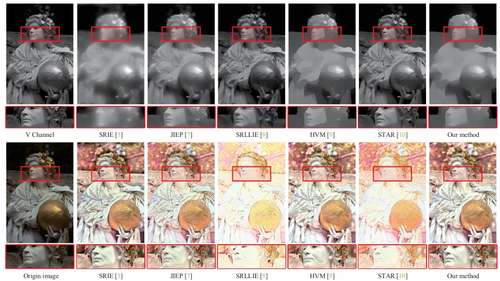

图2 与其他先进方法的比较。第一、二行分别是分解得到的光照分量和反射分量

编辑人:吴建龙、任文琦

专委会责任副主任:张勇东