【论文导读】2024年论文导读第七期

论文导读

2024年论文导读第七期(总第九十八期)

目 录

1 | Relation-Preserving Feature Embedding for Unsupervised Person Re-Identification |

2 | Recovering Generalization via Pre-Training-Like Knowledge Distillation for Out-of-Distribution Visual Question Answering |

3 | Adaptive HEVC Video Steganography with High Performance Based on Attention-Net and PU Partition Modes |

4 | CARE: Cloudified Android with Optimized Rendering Platform |

5 | Transformer-Based High-Fidelity Facial Displacement Completion for Detailed 3D Face Reconstruction |

6 | Blind Quality Evaluator of Light Field Images by Group-Based Representations and Multiple Plane-Oriented Perceptual Characteristics |

01

Relation-Preserving Feature Embedding for Unsupervised Person Re-Identification

作者:王学平1、刘敏2*、王飞2、代建华1、刘安安3、王耀南2

单位:1湖南师范大学、2湖南大学、3天津大学

邮箱:

wang_xueping@hnu.edu.cn, liu_min@hnu.edu.cn

论文:

https://ieeexplore.ieee.org/document/10109197

*通讯作者

1.研究背景和动机

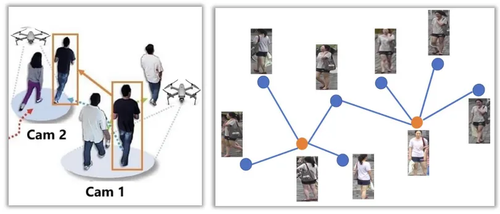

行人重识别(Person ReID)是一个图像检索的子任务,目的是能够在不同拍摄视角下找到目标行人如图1(左图)所示。复杂视频监控场景下数据标注难度高/代价大,基于监督学习的行人重识别方法无法很好解决这个问题。因此,基于无监督学习的行人重识别方法十分重要且具有挑战。大多数无监督行人重识别方法只关注样本本身的信息, 然而由于样本本身的信息有限甚至具有误导性,无法很好解决难样本的问题。考虑样本之间的结构关系信息可以为样本表示学习提供更多有价值的信息,如图1(右图)所示, 当考虑单个样本时,很难判断目标行人(橙色点)是否有相同身份,然而,当考虑多个样本之间的关系时,我们可以比较容易做出正确判断。

图1 行人重识别任务(左)与样本之间的结构关系表示(右)

2. 研究方法

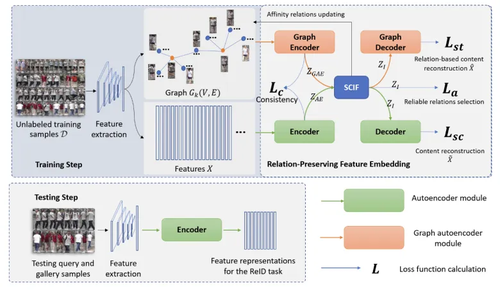

本文提出了一种融合结构关系与内容信息的特征表征方法,提升无监督行人重识别方法的性能。首先构建 K 近邻图来初步建模样本之间的身份关系 A(t) 。使用自编码器对行人图像内容特征进行编码 ZAE = EC(X) ,使用图卷积网络对行人图像之间的结构关系特征进行编码 ZGAE = GEC(A1(t),X)。提出关系-内容信息融合模块依据特征的重要性自适应地合并行人图像的结构关系特征和内容特征 ZF = αZGAE + (1-α)ZAE。使用内容特征解码器和结构关系特征解码器来重建行人图像的内容特征X’和行人图像之间的结构关系特征A1’(t) = sigmoid(ZI·ZIT)。通过联合优化内容重建损失函数和结构关系重建损失函数来优化模型。

图2 研究方法总体框图

由于模型训练前期高度依赖于网络初始参数状态,特征重建结果具有很强的随机性,将导致模型性能不稳定。本文进一步提出了一种近邻关系动态更新策略来减少单个模型重构结果产生偏差的影响。首先根据样本特征之间的相似性构建 K 近邻结构关系图 A1(t) 分别捕获样本之间的局部连接关系。其次,通过关系-内容信息融合模块分别重建出结构关系 A1’(t)。由于缺乏标注,构造的结构关系图中将存在大量冗余连接,因此,将重构的结构关系作为参考,更新图中的连接关系并将更新的关系作为输入用于模型的下一次迭代优化,过程如下:A1(t+1) = γA1(t) + (1-γ)A1’(t)·A1(t) 式中 γ 为权重参数,用来平衡两部分的权重。交替进行模型优化与关系更新,逐步修正行人图像之间错误的连接关系。如图2所示,最终,使用训练好的模型来提取行人的图像特征,实现行人重识别。

3. 实验结果

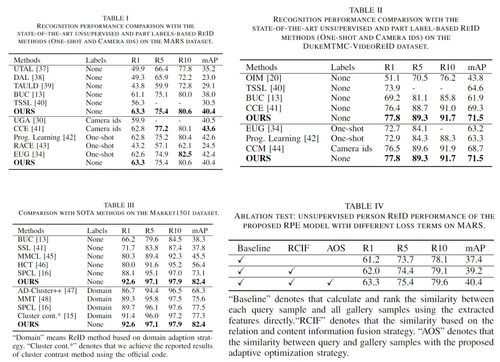

本文实验中将提出的方法与多个无监督/半监督 SOTA 方法进行了对比,实验结果表明本文提出的方法的优越性。表1中展示了 MARS 数据集上实验结果对比,表2中展示了 DukeMTMC-ReID 数据集上实验结果对比,表3中展示了 Market1501 数据集上实验结果对比,消融实验如表4所示。

02

Recovering Generalization via Pre-Training-Like Knowledge Distillation for Out-of-Distribution Visual Question Answering

用于提升分布外视觉问答泛化性能的预训练形式知识蒸馏框架

作者:

宋亚光1,2,3、杨小汕1,2,3、王耀威3、徐常胜1,2,3

单位:

1中国科学院自动化研究所多模态人工智能系统国家重点实验室

2中国科学院大学人工智能学院

3鹏城实验室

邮箱:

songyaguang2019@ia.ac.cn

xiaoshan.yang@nlpr.ia.ac.cn

csxu@nlpr.ia.ac.cn

wangyw@pcl.ac.cn

论文:

https://ieeexplore.ieee.org/document/10119213

1. 引言

随着多模态预训练模型的出现,视觉问答(Visual Question Answering,VQA)任务的性能在“预训练-微调”范式的影响下取得了巨大进展。然而,当下游训练数据和测试数据存在分布偏移的时,即OOD(Out-of-Distribution)问题,基于预训练模型微调的VQA模型可能无法很好的进行泛化。一种直观的思路是将基础模型中的通用知识通过知识蒸馏的方式迁移到微调的VQA模型中,从而实现更好的泛化。然而由于训练数据和测试数据之间偏移的存在,基于特定任务数据蒸馏到的知识的通用性是无法保证的。一种理想的方式是利用预训练数据进行通用知识的蒸馏,但由于数据量过大在实际场景中无法实现。基于以上考虑,本文提出一种新的蒸馏方式,即预训练形式蒸馏,该方法可以在不使用基础模型真实预训练数据集的情况下模拟预训练形式的特征分布,并利用该特征来将基础模型中的知识迁移到微调VQA模型中,进一步提升VQA模型的泛化能力。

2.预训练形式蒸馏方法

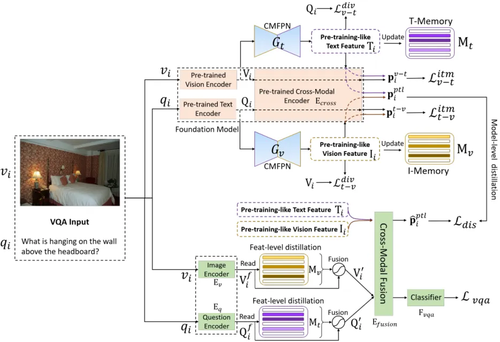

图1 预训练形式蒸馏框架图

为了提升 OOD VQA 中微调模型的泛化能力,本文提出了预训练形式的知识蒸馏框架。图1展示了本文方法的框架。本方法提出基于多模态基础模型来模拟预训练特征分布,并利用它完成基础模型通用知识的蒸馏。本方法主要包含以下三个部分:

(1)特征级别的预训练形式数据预测,该部分用于估计预训练形式的特征分布,该特征分布之后将用于特征和模型级别的蒸馏。特别地,本章利用 VQA 训练数据作为指导并采用两个跨模态特征预测网络来分别估计预训练形式的视觉和文本特征。跨模态特征预测网络基于基础模型提的图文匹配损失和特征差异化损失作为约束进行参数学习,使得特征预测网络可以生成不仅和输入图像和问题特征语义匹配,同时和预训练数据分布更加接近的预训练形式视觉和文本特征。

(2)特征级别蒸馏,本章通过显式融合下游输入 VQA 特征和记忆力模块中存储的预训练形式特征来实现特征级别蒸馏。

(3)模型级别蒸馏,本章通过约束基础模型和下游 VQA 模型对于预训练形式视觉和文本特征的匹配得分来实现蒸馏。基于特征级别和模型级别蒸馏,本方法可以增强微调模型在OOD VQA 任务上的泛化能力。本方法的整个框架可以基于 VQA 分类损失、图文匹配损失、特征差异损失以及蒸馏损失以端到端的方法联合优化。

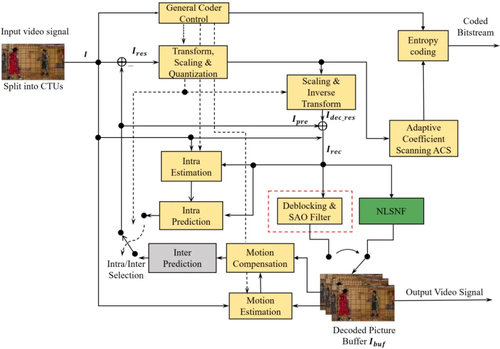

3. 实验结果与分析

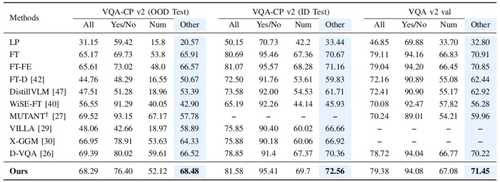

表1 本文方法与目前最优方法在VQA-CP v2数据集和VQA v2数据集上的对比结果

表2 本文方法消融实验

为了提升微调模型在 OOD VQA 任务上的泛化能力,本文提出预测预训练形式的特征并利用它蒸馏基础模型中的通用知识。为了验证本章方法中关键模块的有效性,下面将分别去除本章的关键模块进行消融实验。表2中展示了实验结果。实验结果证明了各个模块的有效性。

4. 总结

本文提出一个新的方法,即预训练形式的知识蒸馏框架,来更好将基础模型中的通用知识迁移到微调模型中从而解决 OOD VQA 问题。未来可以采用更加先进的生成模型,如 VQVAE,来生成更加真实的样本用于分布拟合和知识迁移。

03

Adaptive HEVC Video Steganography with High Performance Based on Attention-Net and PU Partition Modes

基于注意力网络和PU划分模式的高性能自适应HEVC视频隐写

作者:何松翰1,徐达文2, *,杨璘1,梁威鹏1

单位:1宁波大学,2宁波工程学院

邮箱:

2111082349@nbu.edu.cn

dawenxu@126.com

2011082340@nbu.edu.cn

2111082360@nbu.edu.cn

论文:

https://ieeexplore.ieee.org/document/10107476

*通讯作者

1. 研究背景

隐写是一种低感知的保密通信技术,其目的是在数字载体中嵌入秘密信息,这些含密载体将在公共信道中传输,以完成隐秘通信。隐写载体可以采取各种形式,如本文、图像、音频、视频等。视频作为隐写载体具有容量大、对失真不敏感等特点,更利于设计出性能优越的隐写系统。

2. 方法概述

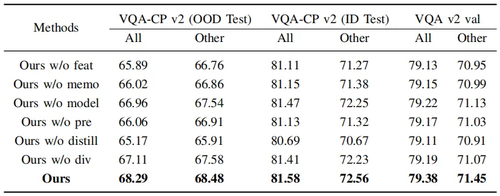

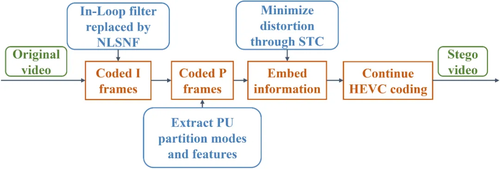

基于PU划分模式的HEVC视频隐写往往会带来较大的比特率增长,容易引起隐写分析者的察觉。针对该问题,本文提出了一种基于注意力网络和预测单元(Prediction Unit, PU)划分模式的HEVC视频隐写方法(如图1所示)。从GOP层次的RDO角度分析了修改PU的总体失真,发现修改PU会造成失真积累,且存在比特率异常增长的问题。为此,设计一种基于改进RDO的自适应失真函数,并使用STC隐写编码实现最小化嵌入失真以抑制比特率增长。同时,提出了一种具有非局部稀疏注意力网络滤波器(Non-Local Sparse Attention-net Filter, NLSNF)的超分辨率卷积神经网络,以取代HEVC中的环路滤波器来重建参考帧(如图2所示),降低隐写视频的比特率成本,提高视觉质量。实验结果表明,与现有的同类隐写算法相比,该方法在相同容量下实现了较低的比特率成本和较高的视觉质量。

图1 所提出的隐写流程图

图2 基于NLSNF的HEVC 编码框架

3. 实验分析

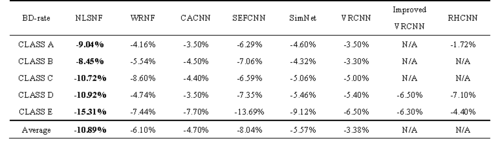

为测试提出的NLSNF性能,本文与其他用于增强视频编码中的环路滤波器的卷积神经网络进行了比较。采用BD-rate来评价各种基于CNN的方法和默认HEVC环路滤波器的性能表现,实验结果如表1所示。

表1 与其他基于CNN算法的性能比较结果

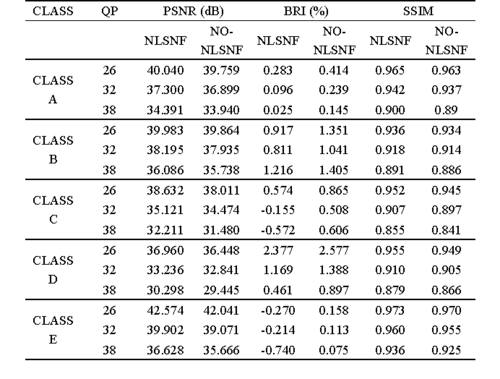

此外,本文进一步进行消融实验以阐述所提出的NLSNF的有效性,表2为使用NLSNF与原始HEVC消融实验。实验结果证明了本文设计滤波器的有效性。

表2 HEVC关于NLSNF的消融实验结果

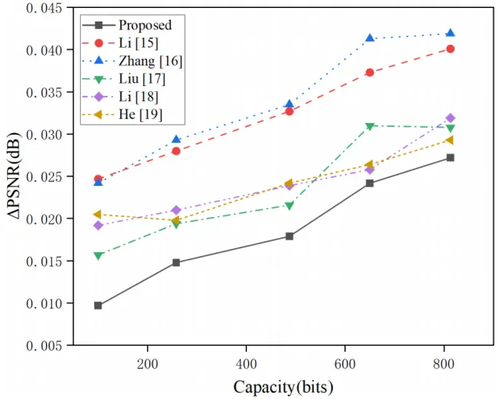

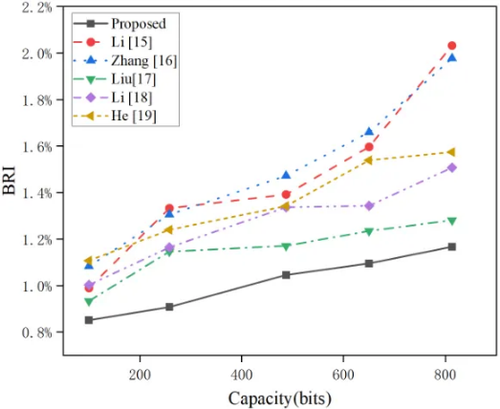

图3与图4分别展示了本文算法与现有基于PU划分模式的隐写算法在相同容量下的PSNR与BRI对比。实验结果表明该算法不仅具有良好的视觉质量,而且具有优秀的比特率增长抑制效果。

图3 不同类型隐写算法的PSN

图4 不同类型隐写算法的BRI

04

CARE: Cloudified Android with Optimized Rendering Platform

CARE:基于高效云渲染平台的云化安卓设计

作者:

项羽心1 ,汤冬劼1,黄蕊2,,姚勇3,解超2, 施奇铭2, 许涛2, Mohammad Reza Haghighat3 , 包佳3, 顾翼成1, 戚正伟1, 管海兵1

单位:

上海交通大学1,英特尔(中国)有限公司2,Intel Corporation(Santa Clara)3

邮箱:

xiangyuxin@sjtu.edu.cn;

018033210001@sjtu.edu.cn;

rui1.huang@intel.com;

yong.yao@intel.com;

chao.xie@intel.com;

qiming.shi@intel.com;

randy.xu@intel.com

mohammad.r.haghighat@intel.com;

cathy.bao@intel.com;

guyicheng98@sjtu.edu.cn;

qizhwei@sjtu.edu.cn;

hbguan@sjtu.edu.cn.

论文:

https://ieeexplore.ieee.org/document/10121642

1. 研究背景和动机

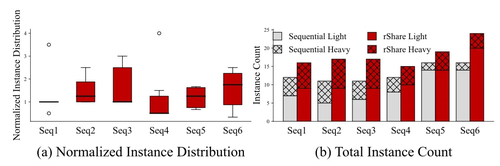

云渲染行业广泛应用 GPU 作为加速器,但当前云渲染系统面临高 CPU 开销带来的 CPU-GPU 负载不平衡问题,这降低了应用性能并造成了 GPU 资源的显著浪费。已有的解决方案包括:(a) v-GPU,利用虚拟机作为隔离单元,使特定 GPU 无需 CPU 转换即可直接加速图形指令;(b) API 转发,允许从其他机器上借用资源,尤其是 CPU资源;(c) c-GPU,用轻量容器托管游戏实例。尽管这些方案都旨在减少资源使用,通过缓解 CPU 的压力来提高 GPU 利用率,但它们都忽略了云渲染的系统级资源冗余问题,即每个实例倾向于占用超出实际需求的所有资源。实际应用评估中,多数情况下,近 50% 系统资源是无效的。面对该挑战,论文提出了 CARE 架构,通过将云渲染系统单体架构转变为云原生架构,减少了系统级冗余,提高了 GPU 有效利用率; 为了进一步缓解 CPU 压力并实现 CPU-GPU 负载平衡,论文还提出了 rShare 调度方案,通过设计高效的动态调度策略,优化了云渲染平台的 CPU 有效利用率和实例密度。

2. 方法概述

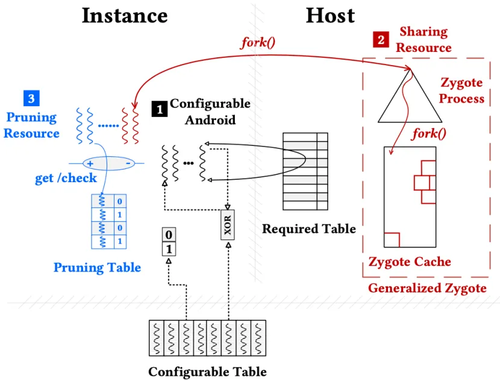

CARE 架构旨在通过云化 Android 系统来优化云渲染的资源利用。如图1所示,CARE设计包括三个主要组件:Configurable Android (CA)、Sharing Resource (SR) 和 Pruning Resource (PR)。CA允许用户根据需求配置所需 Android 服务,SR 促进服务(如 Zygote 进程)在实例间共享,减少重复资源开销。PR 则移除了云环境中不必要的服务,减轻系统负担。这些设计使 CARE 能有效减少资源浪费,提高 GPU 利用率并提升云渲染系统整体性能。

图1 CARE详细设计

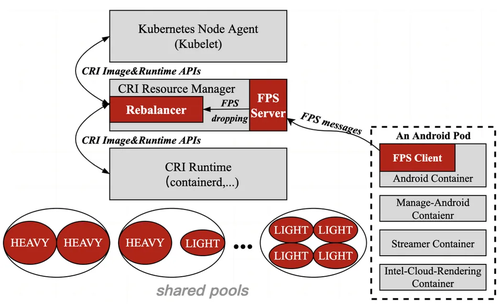

为进一步缓解 CPU 压力,论文提出了高效的 CPU 资源分配调度的云平台设计,rShare。rShare 基于 Kubernetes,通过创建共享 CPU 池,根据 CPU 用量将游戏分为轻型和重型两类,并根据实例的服务质量(QoS)状态进行实时迁移。rShare 通过跟踪每个实例的帧率(FPS)作为 QoS 指标,这允许平台根据游戏实时负载调整资源分配,减少资源浪费并提升系统效率。

图2 rShare架构

3. 实验分析

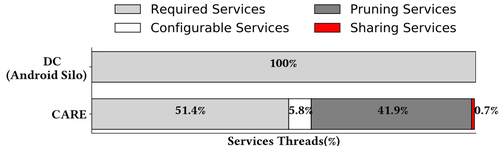

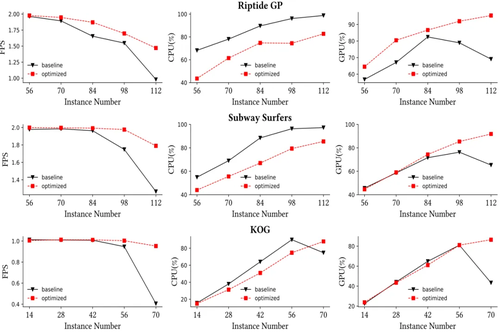

论文使用地铁跑酷(Subway Surfers)、激流快艇(Riptide GP)和王者荣耀(KOG)等游戏作为基准测试,评估了 CARE 的 CPU-GPU 负载平衡和可扩展性。如图3,与未经修改的 Android 相比,CARE 削减了 41.9% 与云渲染无关的系统服务,极大降低了系统冗余。如图4,CARE 显著降低了 CPU 占用并提升了 GPU 利用率,在保证游戏服务质量同时展现了更佳的扩展性。

图3 CARE中的Android系统服务构成

图4 CARE中游戏的CPU-GPU用量与性能表现

此外论文将 rShare 与云平台默认的顺序调度策略对比,如图5所示,rShare 调度机制中实例在 CPU 上分布更紧凑,实例密度更高。在平台实例饱和时,rShare 的实例密度较基线提升 39.4%,证明了其在优化云渲染平台资源分配的有效性。

图5 rShare实例密度

05

Transformer-Based High-Fidelity Facial Displacement Completion for Detailed 3D Face Reconstruction

适用于精细化3D人脸重建的Transformer高保真人脸置换贴图补全

作者:刘仁帅、程耀、黄思飞、李成洋、程轩(通讯作者)

单位:厦门大学、中国移动杭州研究院

邮箱:

chengxuan@xmu.edu.cn

论文:

https://ieeexplore.ieee.org/abstract/document/10113194

1. 研究动机

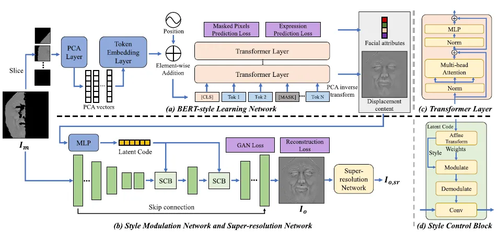

现有的3D建模软件和3D人脸数据库通常使用“基础mesh+置换贴图”的形式来表示精细化3D人脸模型。置换贴图存储了中尺度和细尺度的人脸3D细节,例如皱纹和毛孔等。现有的单视图3D人脸重建方法,由于人脸自遮挡,难以重建出完整的人脸置换贴图。本文提出了一种全新的基于Transformer的置换贴图补全方法DCT,可得到从左耳到右耳的完整置换贴图,从而为现有的单视图3D人脸重建方法补充一个关键模块。

基于Transformer的图像补全方法,通常遵循两阶段方案:首先用Transformer恢复低分辨率下的缺失像素,然后用 GAN 修正高分辨率下的补全结果。尽管这些方法取得了巨大的成功,但在应用于人脸补全时,它们会在两个方面遭到信息损失:1)下采样操作使得 Transformer只为 GAN 产生了一个粗糙的外观先验,从而导致中低级信息丢失。 2)一些有意义的面部语义可以被Transformer很好地捕获并进一步用于补全,但该方向尚未被探索。

2. 方法概述

出于上述考虑,我们在两阶段Transformer图像补全框架中提出了三个新的设计:PCA 分词、BERT学习和样式调制。算法流程如图1所示。首先,我们使用 PCA 分词来代替 Transformer 中的下采样,以保留更有意义的结构。其次,我们让 Transformer 模拟 BERT 中的两个任务,掩码语言模型和下一句预测,用于回复掩码像素和面部属性。第三,我们将 Transformer 的结果编码为潜在代码,以StyleGAN2调制方式指导图像翻译网络。在 FaceScape 数据集和开放数据上的实验表明,与其他基于 Transformer或基于 GAN 的补全方法相比,DCT具有更好的表现。

图1 算法流程图

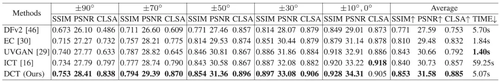

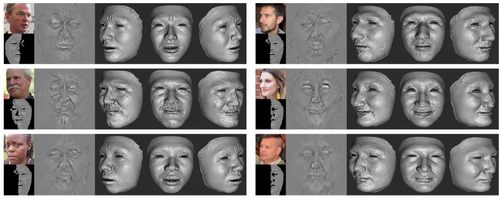

3. 实验

表1展示了本文提出的补全方法DCT和其他图像补全方法在FaceScape不同人脸角度下的定量比较。在图像质量、表情识别率等指标上,DCT均取得了最好效果。图2展示了本文提出的精细化3D人脸重建方法DCT在大角度(侧脸)人脸图像上的重建效果,DCT能够恢复出合理的、完整的人脸3D细节。

表1 不同图像补全方法在FaceScape数据集上的定量比较

图2 从大角度(侧脸)人脸图像重建精细化3D人脸模型

06

Blind Quality Evaluator of Light Field Images by Group-Based Representations and Multiple Plane-Oriented Perceptual Characteristics

作者:

柴雄力1,邵枫1,姜求平1,王雪津2,徐龙3,Yo-Sung Ho4

单位:

1宁波大学信息科学与工程学院,2福建理工大学计算机科学与数学学院,3中国科学院国家天文台,4韩国光州科学技术院

邮箱:

shaofeng@nbu.edu.cn

论文:

https://ieeexplore.ieee.org/document/10105489

代码:

https://github.com/zerosola/NR-LF-QAE

1. 引言

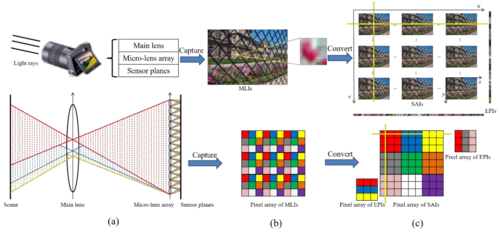

由于无参考光场图像质量评价(NR LF-IQA)的目标是通过测量多视点间的一致性(如几何、清晰度、色彩等)来反映光场内在空间-角度信息的质量退化程度,因此在设计NR LF-IQA方法时需要考虑光场质量退化存在的几个特性:1)由于光场的质量退化会影响多个视点相同场景之间的一致性,一个合理的想法是计算相应视点区域之间的相似度。采用特征对齐操作可以更直观地测量视点一致性;2)光场图像按空间坐标叠加形成SAIs平面和按角度坐标排列形成EPIs平面是光场重要的两个特性。对这两个平面进行特征表征可以有效度量光场的感知质量;3)在构建NR LF-IQA方法时,需综合考虑视点一致性和空间-角度特征。图1展示了光场各平面的成像表示。

图1 光场成像表示。(a)简化后的4D光场示意图;(b)MLIs平面的像素排列及相应图像内容;(c)SAIs和EPIs平面的像素排列及相应图像内容。

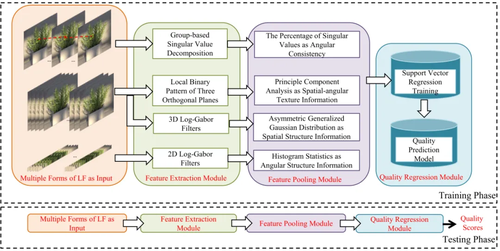

2. 方法

围绕特征对齐和空间-角度特征表示,本文提出了一种基于组的信号表示和多平面感知特性分析的光场盲质量评估器,主要可以概括为以下几点:

1)由于相邻视图之间的视差通常较小,成像内容的位移视差基本由角坐标决定。本文设计了特征对齐模块来计算重叠视口区域的内容一致性。光场的中心视图被依次划分为多个块,这些块与其对应的属于其他视图的块对齐为一组。通过分析奇异值分解(SVD)中奇异值的头部百分比来计算对齐视图堆栈的一致性。

2)为了描述光场的纹理信息,采用LBP-TOP来分别计算空间域和时间域的纹理特征。由于三个平面相互正交,除了在空间域提取空间特征外,还能够在时间域提取角度特征。通过在多个平面上联合进行直方图统计,可以有效地描述光场的空间-角度纹理特征。

3)为了描述光场的结构特征,采用Log-Gabor滤波器对4D LFIs进行滤波,以模拟视觉信号响应。具体而言,设计了针对SAIs的3D Log-Gabor滤波器来获取空间感知结构特征,并采用多方向的2D Log-Gabor滤波器在EPIs平面提取角度结构信息。图2展示了所提出的质量评价模型。

图2 所提出的光场盲质量评估框架

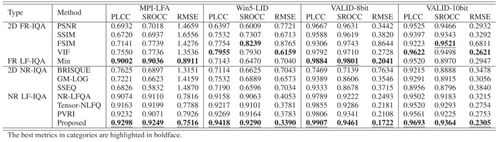

3. 实验结果

本文方法与其他11种主流方法在MPI-LFA, WIN5-LID 和VALID数据库进行了实验,并在表1中列出了这些2D FR-IQA/FR LF-IQA/2D NR-IQA/NR LF-IQA方法对于光场质量评价任务的性能。基于对比结果,可以看出本文方法不但在无参考光场质量评价任务中处于领先状态,还可以与全参考光场质量评价方法的性能相比,具有较高的评价准确性。

表1 在MPI-LFA, WIN5-LID 和VALID数据库上的性能比较

编辑人:吴建龙、任文琦

专委会责任副主任:张勇东