【论文导读】2024年论文导读第八期

论文导读

2024年论文导读第八期(总第九十九期)

目 录

1 | Semantic Distance Adversarial Learning for Text-to-Image Synthesis |

2 | Knowledge-Enhanced Causal Reinforcement Learning Model for Interactive Recommendation |

3 | Exploiting Spatial and Angular Correlations With Deep Efficient Transformers for Light Field Image Super-Resolution |

4 | Multi-Modal Structure-Embedding Graph Transformer for Visual Commonsense Reasoning |

5 | Rethinking the Person Localization for Single-Stage Multi-Person Pose Estimation |

01

Semantic Distance Adversarial Learning for Text-to-Image Synthesis

作者:袁博闻1, 盛业斐1, 鲍秉坤*1.2, Yi-Ping Phoebe Chen3, 徐常胜4.5.2

单位:1南京邮电大学,2鹏程实验室,3La Trobe University,4中国科学院大学,5中国科学院自动化研究所

邮箱:

yuanbw0925@gmail.com;

ysheng990618@gmail.com;

bingkunbao@njupt.edu.cn;

phoebe.chen@latrobe.edu.au;

csxu@nlpr.ia.ac.cn.

论文:

https://ieeexplore.ieee.org/abstract/document/10132043

代码:

https://github.com/NJUPT-MCC/SEMA

*通讯作者

1.研究背景

文本到图像生成是一个跨模态生成任务,它需要将文本描述作为输入,生成一个逼真且在语义上一致的图像。为了保证语义的一致性,先前的一些研究重新对合成图像进行描述,并且与给定的文本描述进行对齐。

然而,现有的重新描述模块缺乏对其训练目标的明确建模,如图1 (a)。使用预训练的重新描述模块会受到对抗性图像样本的影响,从而生成离散的图像特征而非完整的图像内容,难以保证生成图像质量;而使用与生成器一起进行优化的重新描述模块则会被迫从错误图像或缺乏完整内容的图像中生成看不见的语义,难以保证重描述文本与实际图像内容语义一致。

图1 (a) 现有的重新描述模块,会受到对抗性图像样本、未见语义、错误图像内容的影响;(b) SEMA 在保持生成器的目标与以往一致的情况下,明确规范了重新描述模块的目标

为此,我们提出了语义距离对抗学习的文本到图像生成框架,如图1 (b). 我们从两个方面加强语义一致性:1)我们引入了图像生成器和重新描述模块之间的对抗学习,以增强再描述模块的描述文本的质量,确保对图像内容的准确重新描述,从而增强图像生成质量,减少对抗性图像样本的生成。 2)我们引入了双重语义距离判别(SEM distance),用于表征匹配文本或图像对之间的语义相关性。未见语义和错误内容将会被赋予较大的语义距离。并且,所提出的判别方法还简化了模型训练过程,无需优化多个判别器。在CUB Birds 200和MS-COCO数据集上的实验结果表明,所提出的模型优于目前的最先进方法。

2. 方法概述

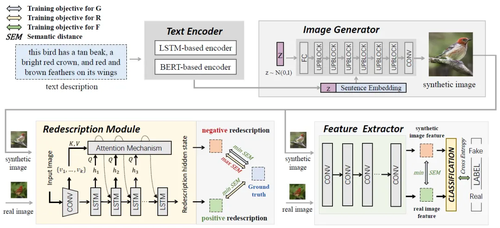

图2 SEMA:语义距离对抗学习的文本到图像生成框架

本文提出的框架如图2所示,它由文本编码器、图像生成器、图像再描述模块以及图像鉴别模块构成。我们保持生成器的训练目标不变,即最小化重描述文本与原始文本之间的语义差异。在此基础上,我们进一步创新地将合成图像的重描述作为负样本,而真实图像的重描述作为正样本。并且,我们将再描述模块的训练目标设置为拉近给定文本与正样本的距离,拉远给定文本与负样本的距离。这一目标不仅通过拉远负样本与给定文本的差异,为合成图像提供了更严格的监督,而且通过最小化正样本与给定文本之间的语义差异,进一步提升了反映图像内容的能力。此外,我们引入语义距离判别,将生成器与再描述模块、生成器与鉴别器之间的对抗过程均使用语义距离作为损失进行对抗训练,这种方法能够更好的保证语义一致性,同时简化模型。

3. 实验分析

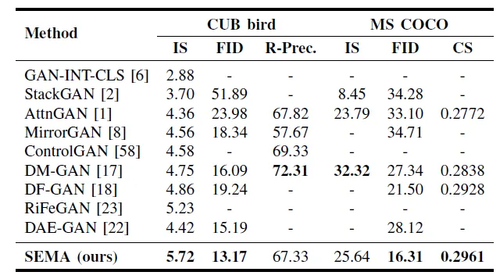

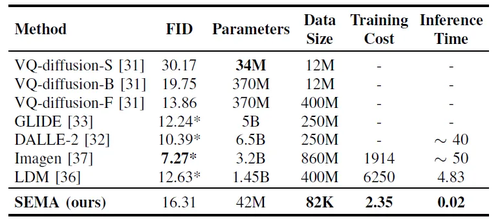

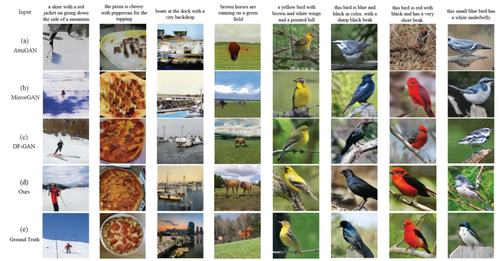

我们在CUB bird和MS-COCO这两个数据集上开展了实验,表1和表2提供了与现有基于GAN的方法以及基于扩散模型的方法的定量比较,图3提供了与现有基于GAN的方法生成图像比较,可以发现,我们的方法与现有基于GAN的方法相比在图像生成的真实性和语义一致性上都取得了最佳表现,与基于扩散模型的方法相比,我们的方法可以在训练数据极少的情况下取得良好表现,同时能够快速生成所需图片。

表1 与其它基于GAN的文本生成图像模型的性能比较。最佳结果使用加粗表示

表2 与其它基于扩散模型的文本生成图像模型的性能比较。最佳结果使用加粗表示

图3 其它基于GAN的文本生成图像模型的生成图像比较

02

Knowledge-Enhanced Causal Reinforcement Learning Model for Interactive Recommendation

作者:

聂为之1、文昕1、刘婧1、陈佳伟2、吴剑灿3、靳国庆4、吕静5、刘安安1,6

单位:

1天津大学,2浙江大学,3中国科学技术大学,4人民网股份有限公司,5北京达佳互联信息技术有限公司,6合肥综合性国家科学中心人工智能研究院

邮箱:

weizhinie@tju.edu.cn, wenxin113@tju.edu.cn

论文:

https://ieeexplore.ieee.org/document/10125070

1. 引言

鉴于其卓越的动态交互建模能力和较为经济的训练成本,离线强化学习(Offline RL)通常被用于构建交互式推荐系统。交互式推荐过程由此可以被描述为一个马尔可夫决策过程(MDP),其中推荐系统(RL代理)根据用户状态依次向用户(RL环境)推荐物品(RL动作),并接收用户满意度反馈(RL奖励),目标是最大化整个交互过程中的长期累积用户满意度。然而,由于物品空间巨大,离线强化学习模型不可避免地会受到数据稀疏问题的影响,难以从有限数量的历史用户-物品交互中有效挖掘用户对物品的偏好。为此,本文提出一个知识增强的因果强化学习模型KCRL(如图1所示),从RL奖励函数和用户状态表征两个方面增强离线强化学习框架,缓解数据稀疏问题。

图1 知识增强的因果强化学习模型

2. 方法

KCRL模型由群组偏好注入的因果用户模型(GCUM)、知识增强的状态编码器(KSE)和RL策略模块(RLPM)组成,学习过程包含用户模型学习和RL策略学习两个阶段。用户模型学习阶段,利用离线历史数据训练GCUM学习真实用户偏好,估计用户满意度。RL策略学习阶段,基于马尔可夫决策过程训练RLPM学习推荐策略。训练过程中,用户满意度奖励由已学习的GCUM提供,每个时刻的用户状态由KSE生成,两个组件分别介绍如下:

(1)GCUM:离线交互数据的稀疏性导致难以从中捕获完整的用户兴趣。本文分析快手推荐平台的真实交互数据发现,基于用户属性信息对用户分组后,用户群组与用户呈现出相似的偏好,并且群组交互更为密集。因此,GCUM通过因果推理引入与用户潜在偏好一致的用户群组偏好(定义为群组效应)来建模用户满意度,以实现对不完整用户偏好的补偿。群组效应的计算一方面考虑了多个属性维度的群组偏好以更全面地整合偏好信息,另一方面通过建模用户与群组的隶属关系来去除不符合用户个性化偏好的群组偏差。

(2)KSE:KSE集成当前时刻之前的用户交互物品、用户满意度反馈,以及用户特征来编码当前时刻的用户状态。为进一步补充交互信息,本文提取知识图谱先验信息来丰富用户与物品特征。知识图谱基于用户群组属性、物品类别标签和部分历史交互进行构建,以实现对物品-物品、用户-用户和用户-物品关联的充分挖掘。状态编码过程包括知识图谱构建、基于知识图谱的特征表示和状态表征生成三个步骤,如图2所示。

图2 知识增强的状态编码器

3. 实验

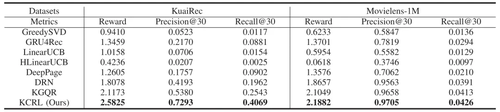

本文在两个公开数据集上对所提出的方法进行测试。与其他交互式推荐方法的对比实验(表1)表明,所提出方法能够获得更大的用户满意度奖励和更优的推荐准确性。此外,本文研究了不同算法获得相同推荐满意度所需的交互数量(表2)。结果表明本文算法可以更有效地使用交互数据,在交互较少的场景下也可以保持良好的推荐性能。

表1 不同算法的总体性能比较

表2 不同方法获得相同奖励分数所需的交互数量(M)

03

Exploiting Spatial and Angular Correlations With Deep Efficient Transformers for Light Field Image Super-Resolution

作者:

丛睿轩,盛浩,杨达,崔正龙,陈荣山

单位:

北京航空航天大学计算机学院,杭州市北京航空航天大学国际创新研究院(北京航空航天大学国际创新学院),澳门理工大学应用科学学院

邮箱:

congrx@buaa.edu.cn,shenghao@buaa.edu.cn,da.yang@buaa.edu.cn,zhenglong.cui@buaa.edu.cn,rongshan@buaa.edu.cn

论文:

https://ieeexplore.ieee.org/document/10143279

代码:

https://github.com/Congrx/LF-DET

1. 简介

全局上下文信息对于全面的场景理解尤为重要。它有助于澄清局部混乱并平滑预测以实现准确且连贯的结果。然而,大多数光场处理方法仅利用卷积层来建模空间和角度信息。有限的感受野限制了它们学习光场结构中的全局上下文。

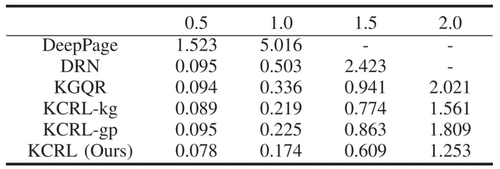

为此,本文提出一种深度高效的Transformer网络LF-DET用于光场空间超分辨率。核心模块是空间角度可分离Transformer编码器,具有下采样空间建模和多尺度角度建模两种建模策略。具体来说,前者利用下采样卷积层来缓解捕获每个子孔径图像内的空间信息时计算量巨大的问题,从而在有限的内存下级联更多的Transformer不断增强特征表示;后者处理三种规模的宏像素区域,以提取和聚合针对不同视差范围的角度特征从而很好地适应视差变化。此外,LF-DET还通过动态位置编码捕获周围像素之间的强烈相似性,以填补Transformer缺乏局部信息交互的空白。大量实验证明LF-DET实现显着的性能改进。

2. 方法

规定4D光场为,空间角度可分离Transformer编码器整体结构如图1所示,其中下采样空间建模包含K个级联的空间Transformer处理每个子孔径图像构成的长度为的序列,在计算自注意力前通过且步长为的下采样卷积缩小和的规模,其余和普通Transformer相同;多尺度角度建模包含3个并行的角度Transformer,分别处理规模为1×1、2×2、3×3的宏像素区域来提取针对不同视差范围的角度特征(序列长度分别UV、4UV、9UV),然后利用空间注意力机制对三个区域宏像素特征进行融合。

图1 我们提出的空间角度可分离Transformer编码器

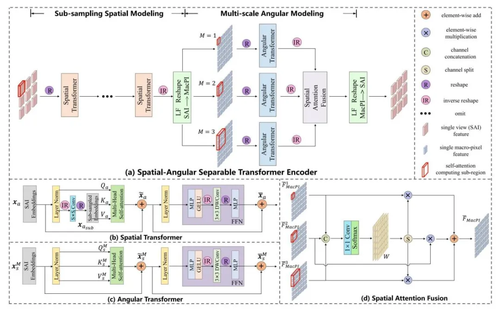

图2说明了本文提出的光场空间超分辨网络LF-DET整体架构,它应用了编码器-解码器结构。在特征提取阶段,将卷积网络的局部特性和Transformer的全局特性相结合,提高特征表示能力。具体而言,我们在对光场序列化时使用残差块来引入局部信息,然后堆叠多个空间角度可分离Transformer编码器用于全局特征提取。在解码阶段,利用一个分层特征聚合(HFA)模块以将具有不同表达水平的多尺度编码特征沿着由深层到浅层的路径进行融合。最后,将聚合的特征馈送到上采样模块获得光场空间超分辨结果。

图2 我们提出的光场空间超分辨网络LF-DET

3. 实验

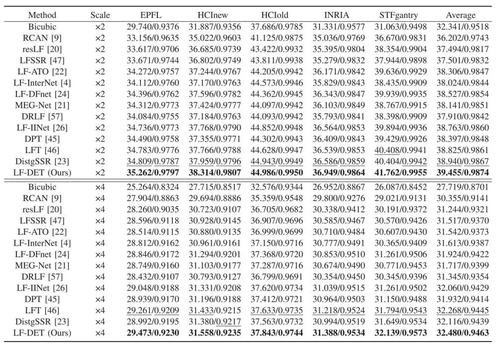

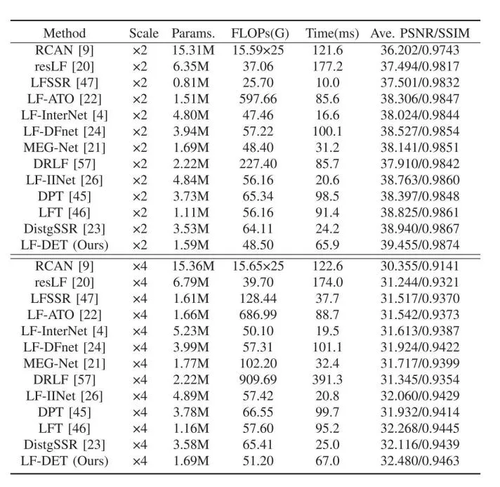

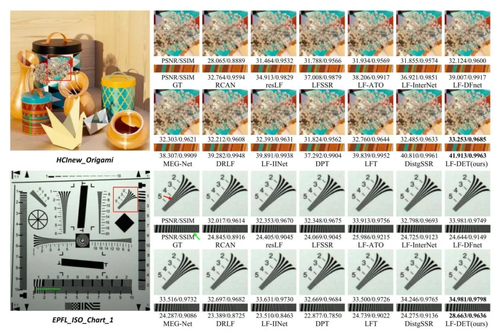

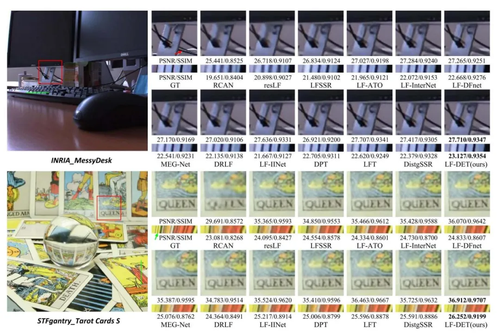

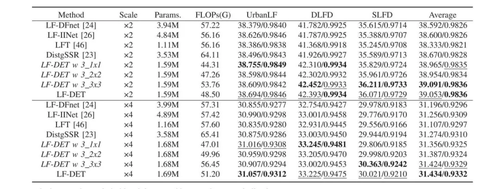

本方法在5个光场数据集HCInew、HCIold、EPFL、INRIA、STFgantry构成的混合数据集上进行实验,表1提供了与先进方法的定量比较,图3和图4分别提供了×2和×4的光场空间超分辨视觉比较结果。此外,表2还从模型参数量、运算量、运算时间提供了各个方法的效率,可以看出我们的方法在所有测试集上都取得了最佳表现,并且在模型效率的权衡上也有均衡的表现。通过广泛的实验可以证明,LF-DET通过巧妙地整合了CNN和Transformer以及利用提出的下采样空间建模和多尺度角度建模两种建模策略,在计算成本和模型性能之间实现了良好的平衡。

表1 ×2和×4光场空间超分辨PSNR/SSIM指标比较,最好结果加粗显示,次好结果下划线显示

表2 ×2和×4光场空间超分辨计算效率(网络参数、运算量、时间)比较,其中运算量和时间是在规模为5×5×32×32的光场像素块上计算的结果

图3 在HCInew和EPFL数据集上×2光场空间超分辨视觉比较

图4 在INRIA和STFgantry数据集上×4光场空间超分辨视觉比较

此外,在多视差光场数据集DLFD、SLFD以及城市光场数据集UrbanLF上的进一步消融实验也证明了所提出的多尺度角度建模能够兼顾不同视差范围下的光场超分辨性能。

表3 ×2和×4光场空间超分辨在具有不同视差规模的DLFD、SLFD、UrbanLF光场数据集的PSNR/SSIM指标比较,最好结果加粗显示,次好结果下划线显示

04

Multi-Modal Structure-Embedding Graph Transformer for Visual Commonsense Reasoning

作者:朱健,王瀚漓,何斌

单位:同济大学

邮箱:

jianzhu@tongji.edu.cn

hanliwang@tongji.edu.cn

hebin@tongji.edu.cn

论文:

https://ieeexplore.ieee.org/document/10132535

代码:

https://github.com/Tongji-MIC-Lab/MSGT

主页:

https://mic.tongji.edu.cn/9b/56/c9778a301910/page.htm

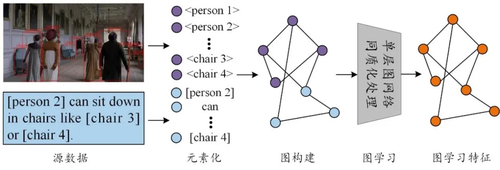

1. 研究动机

视觉常识推理是一种复杂的跨模态认知任务,需要细粒度的模态内与模态间的关联建模以实现精准推理。对于关联挖掘与表达,图形式具有先天优势。然而,如图1所示,现存的基于图学习的视觉常识推理方法存在异构结点同质化处理和图学习网络表征能力有限等问题。因此,本文提出了一种基于多模态结构嵌入图演化学习的视觉常识推理方法,更合理且差异化地进行多模态异构图的结点表征和关联建模。

图1 现存的基于图学习的视觉常识推理方法常见流程

2. 方法

本文所提出方法框架如图2所示。该框架由三部分组成:多模态结构嵌入模块、用于上下文关联和推理的结构注入图转换器模块和评分池化推理模块。具体地,首先将图像区域、问题和回答数据输入到预训练网络中特征提取,并根据初始特征在多模态结构嵌入模块中考虑多模态数据固有特征构造回答-图像结构嵌入图和回答-问题结构嵌入图。然后,模型采用多层结构注入图转换器,将嵌入结构先验注入到语义关联矩阵中,用于图结点特征和结构表示演化。最后,评分池化推理模块自适应地从元素层面和特征维度层面融合图特征进行推理。

图2 基于多模态结构嵌入图演化学习的视觉常识推理方法架构

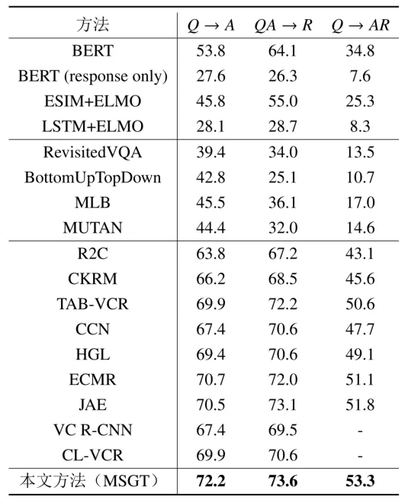

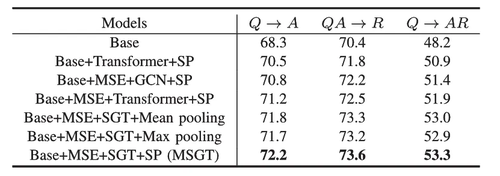

3. 实验

本文在视觉常识推理基准数据集上进行了实验,总体实验结果如表1所示,证明了本文提出方法性能的优越性。

表1 本文方法与对比方法在视觉常识推理数据集上的准确率对比实验结果

针对本文提出的多模态结构嵌入模块(MSE)、结构注入图转换器(SGT)和评分池化模块(SP)的消融实验结果如表2所示,证明了本文提出模块的有效性。

表2 本文方法在视觉常识推理数据集上消融实验的准确率结果

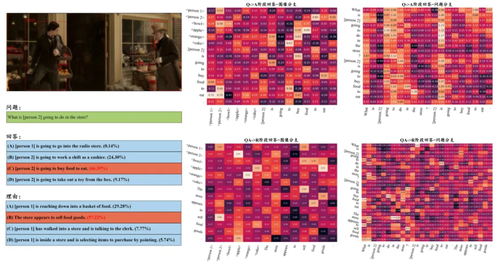

本文方法进行视觉常识推理的实例如图3所示,左图为预测结果,右图为模型学习到的拓扑关联,可以发现模型可以较好地提取出关键的推理线索从而实现精准推理。

图3 本文方法进行视觉常识推理的实例

05

Rethinking the Person Localization for Single-Stage Multi-Person Pose Estimation

作者:

金磊、赵健

单位:

北京邮电大学、中国电信人工智能研究院,西北工业大学

邮箱:

jinlei@bupt.edu.cn;jian_zhao@nwpu.edu.cn

论文:

https://ieeexplore.ieee.org/abstract/document/10141888

1. 简介

多人姿态估计的单阶段方法因其能够同时生成人体位置定位和身体结构感知的简化流程而受到了广泛关注。然而,现有方法大多分别处理这两个部分,从而有可能导致结果不理想,例如,候选姿态对人位置定位的置信度高,但对结构的估计较差。如图1所示,Score代表人体中心定位置信度,OKS代表姿态回归质量,现有SOTA方法出现了人体中心置信度高,而相应姿态估计结果差的现象。

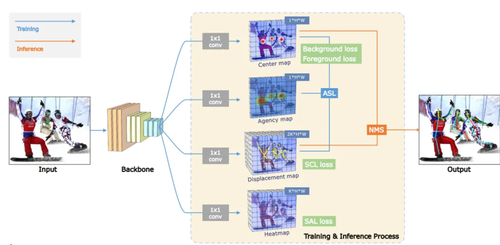

为此,我们提出了一种简单而有效的方法,即结构引导的人体定位(Structure-guided Person Localization,SPL),如图2所示,联合利用这两个方面的优点来解决多人姿态估计问题,并提出了两个互补的创新点。首先,我们提出将身体结构感知纳入到人体位置定位中,因此,我们引入结构引导中心学习(Structure-guided Center Learning,SCL),以统一位移图中身体结构感知的质量与中心图中人体存在的置信度,从而实现面对极端姿态依然准确的关键点位置定位结果。简单的说,我们通过结构引导中心学习,让模型预测的不再是人体中心位置,而是利用自适应的方式找出更能准确预测整个人体姿态的位置。其次,为了促进SPL的端到端训练,我们提出了高效的基于代理的尺度自适应学习(Agency-based Scale-adaptive Learning,ASL),在中心图和GT标签之间额外引入了一个代理图,并增加尺度自适应。在COCO和CrowdPose具有挑战性的基准测试集上进行的综合实验, 清晰地验证了所提框架的优越性, 取得了新的最先进的单阶段多人姿态估计结果, 其中SPL在COCO test-dev2017和CrowdPose测试集上分别获得了72.1和69.5的AP分数。

图1 多人人体姿态估计预测结果

图2 SPL框架。

其中Center map和Agency map用于指示人体中心的位置。Displacement map指示了从人体中心到其他关键点的偏移。Heatmap是辅助分支,预测关键点位置的高斯分布。在训练期间,Displacement map和Agency map与SCL损失一起训练。Center map的前景与Agency map一起训练,Center map的背景以0为目标进行训练。在推理过程中,Center map和Displacement map用于输出最终姿态。

编辑人:吴建龙、任文琦

专委会责任副主任:张勇东