【论文导读】2024年论文导读第九期

论文导读

2024年论文导读第九期(总第一百期)

目 录

1 | Rethinking Batch Sample Relationships for Data Representation: A Batch-Graph Transformer based Approach |

2 | ReSParser: Fully Convolutional Multiple Human Parsing With Representative Sets |

3 | An Efficient Latent Style Guided Transformer-CNN Framework for Face Super-Resolution |

4 | A Semi-Supervised Underexposed Image Enhancement Network with Supervised Context Attention and Multi-Exposure Fusion |

5 | Few-Shot Class-Incremental Audio Classification Using Dynamically Expanded Classifier With Self-Attention Modified Prototypes |

01

Rethinking Batch Sample Relationships for Data Representation: A Batch-Graph Transformer based Approach

作者:

汪茜茜1,江波1(通讯作者),王逍1,唐金辉2,罗斌1

单位:

1安徽大学,2南京理工大学

邮箱:

sissiw0409@foxmail.com

jiangbo@ahu.edu.cn

wangxiaocvpr@foxmail.com

jinhuitang@njust.edu.cn

luobin@ahu.edu.cn

论文:

https://ieeexplore.ieee.org/document/10144585

1. 引言

学习鲁棒且具备判别力的图像特征表示是计算机视觉领域中至关重要的基础性任务。随着深度学习技术的持续演进,卷积神经网络(CNN)在图像表示学习领域得到了广泛应用。然而,CNN的局限性在于其仅能对图像的局部信息进行建模,难以全面捕捉图像的全局上下文信息。近年来,Transformer模型凭借其捕捉视觉单元之间远程依赖关系的能力,在计算机视觉任务中受到了越来越多的瞩目。最新研究进一步提出,利用Transformer来深入探索图像表示学习中样本级的相关性。不过,这些模型大多沿用了传统Transformer的设计思路,往往过度聚焦于图像之间的视觉关系建模,而忽视了图像之间语义/标签相关性这一关键线索。此外,这些模型普遍采用标准的自注意力机制,通过整合所有其他样本的信息来学习每张图像的表示。这种做法虽然有助于获取更丰富的信息,但不可避免地引入了一些冗余信息,且对噪声样本的干扰尤为敏感。

2. 方法概述

在本文中,提出了一种新的批处理图Transformer模型(BGFormer),该模型为数据表示和学习任务提供了一个通用的即插即用模块。具体如下:

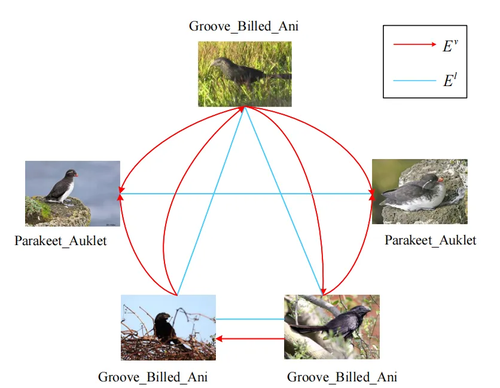

1)它采用一种灵活的图形模型,称为批处理图,它在一个统一的模型中同时编码样本的视觉和语义/标签关系,从而对每个小批量样本间的关系进行更深度建模,如图1所示。此外,本文提出的批处理图借鉴稀疏图表示的思想来探索样本之间的邻域关系,从而鲁棒地执行噪声样本。

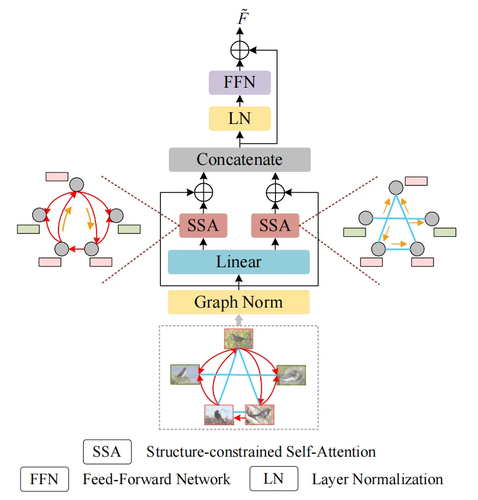

2)基于构建的批处理图,开发了一种新的图学习机制,称为批处理图Transformer(BGFormer),其目的是通过在批处理图上传递消息来学习小批量样本间的上下文表示,如图2所示。BGFormer块的核心是双重结构约束自注意力机制(SSA),可以同时捕获视觉和语义关系从而进行数据表示学习。

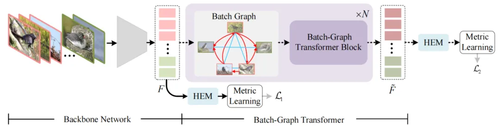

为了验证所提出的BGFormer模型的有效性,将BGFormer集成到度量学习任务框架中,并提出了一种基于BGFormer的度量学习架构,如图3所示。

图1 批处理图的示例图

图2 BGFormer块的概述图

图3 基于BGFormer的度量学习框架

3. 实验分析

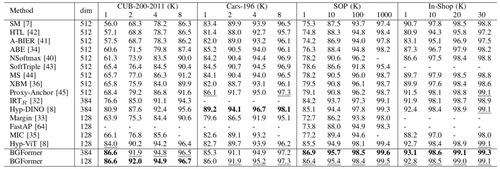

在四个公共流行的数据集上的大量实验证明了所提出的BGFormer的有效性和优越性,与最新相关方法的性能对比结果如图1所示。

表1 本文方法与最新相关方法性能对比结果,加粗的表示最优结果

为了进一步验证BGFormer有效性,对Cars数据集上排名前4的结果进行了定性可视化分析,如图4所示。图中绿色边界为真阳性样本,红色边界为假阳性样本。可以发现:1).在提出的BGFormer中可以找到更多的真阳性。2). 本文提出的BGFormer能够准确识别出不同颜色的同类型汽车,表明BGFormer方法可以缩小类内差距。

图4 定性可视化结果

02

ReSParser: Fully Convolutional Multiple Human Parsing With Representative Sets

基于关键点集合的全卷积人体解析框架

作者:

代燕,陈晓嘉,王轩瀚,庞妙辉,高联丽,申恒涛

单位:

电子科技大学

邮箱:

yandai1019@gmail.com;

josonchan1998@gmail.com;

wxuanhan@hotmail.com;

lianli.gao@uestc.edu.cn;

shenhengtao@hotmail.com

论文:

https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=10138431

1. 引言

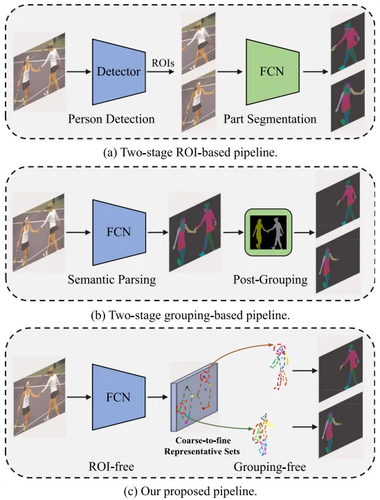

多人人体解析旨在将人体部位分割成不同的语义区域,并将每个区域与相应的人体实例关联起来。现有的解析方法通常采用两阶段框架来处理这两个子任务,包括先检测后解析的自顶向下框架和先解析后分组的自底向上框架。然而,以上的两阶段框架在解决多人人体解析问题时仍然面临着两大挑战:1)子任务间的依赖关系和性能瓶颈:例如在自顶向下框架中,通常需要一个行人检测模型来处理图像中各个行人的区分问题。在此基础之上,构建针对单人的人体解析模型,实现对已检测的行人进行部位轮廓解析。在这种设定之下,如果行人检测模型的性能不佳,对图像中的行人检测能力不足,则将会导致单人人体解析模型在部位分割上的性能下降。2)计算负担和推理效率:上述两阶段框架处理两个子任务通常建立在两个独立的推理过程,推理时间将会依赖于第一阶段的输出结果,因此带来了显著的计算负担。为了解决这两个问题,本文提出了一种基于人体代表性点集的多人解析方法,通过估计每个行人最具代表性的点,协同处理行人区分和部位解析两个子任务,统一解决任务依赖和推理效率问题。通过在CIHP和MHP两个数据集上的实验,证明了本文方法在解析性能和效率上的有效性。

图1 现有框架和本文所提出的框架对比

2. 方法

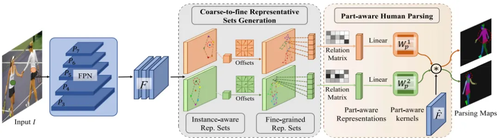

为了应对以上的挑战,本文提出了一种基于人体代表性点集的多人解析方法ReSParser,该方法被设计为一个层次推理过程,其中包括两个主要步骤:1)由粗粒度到细粒度的人体代表性点集生成模块;2)部位感知的人体解析模块。如图2所示,给定一个输入图像,首先使用一个特征提取网络来获取图像级别的特征F。在此基础上,本方法增加了一个用于行人定位的中心点估计分支和一个用于预测粗粒度人体代表性点集的分支。粗粒度人体代表性点集是由粗粒度的身体部位的中心决定的,这反映了人体实例的全局上下文和语义上显著的点。具体而言,本方法将粗粒度的人体代表性点集记作Rc={rci}{i=1}M,其中rci为第i个粗粒度部位的中心,而M则为粗粒度部位的个数。进一步地,每一个粗粒度点集将被分解为具有许多特征点的细粒度代表性点集。这一步骤的目的是在保持全局上下文信息的同时,对每个部位的形状和特征进行更精细的描述,以实现更准确的部位语义分割。具体而言,本方法将细粒度的人体代表性点集记作Rv={rvj}{j=1}L,其中rvj为第j个细粒度部位关键点,而L则为细粒度部位关键点的个数。最后,为了解析出人体部位的语义信息,本方法在细粒度代表性点集的基础上自适应地聚合部位表征并生成用于部位分割的部位感知卷积核,该卷积核将与图像特征进行卷积生成最后的解析结果。以上整个解析过程是端到端的,无需借助先验检测或后分组。

图2 算法流程图

3. 实验

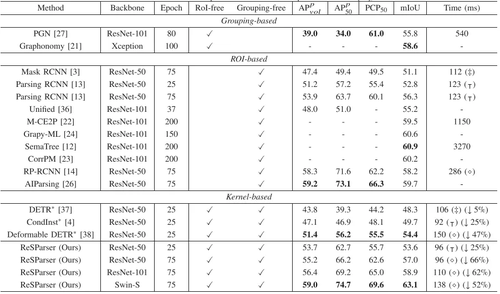

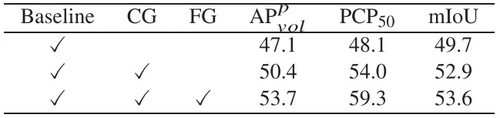

本文将所提出的方法在现有的人体解析数据集上进行对比,实验结果表明本文提出的框架的优越性。具体来说如表1所示,本框架取得了与两阶段方法相似的性能,但推理效率大大提升。另外,表2展示了本框架各个模块在CIHP数据集上的消融实验,该实验结果证明了各个模块的有效性。

表1 CIHP数据集上对比实验

表2 本框架的消融实验

03

An Efficient Latent Style Guided Transformer-CNN Framework for Face Super-Resolution

作者:

齐浩然, 邱钰苇, 罗兴, 金枝(通讯作者)

单位:

中山大学智能工程学院前沿视觉实验室FVL

邮箱:

jinzh26@mail.sysu.edu.cn

论文:

https://ieeexplore.ieee.org/document/10145603

代码:

https://github.com/FVL2020/ELSFace

1.研究背景和动机

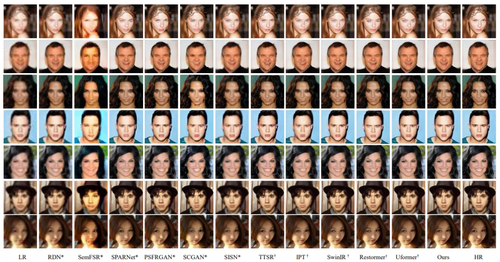

图1 我们所提出的模型和其他基于Transformer或CNN架构方法的可视化对比

在人脸超分辨率(FSR)任务中,精确恢复面部纹理并保持面部轮廓以获得逼真的高分辨率面部是非常重要的。尽管几种基于CNN的FSR方法取得了很好的性能,但由于局部卷积的限制,它们在恢复面部轮廓方面表现不佳。相比之下,使用自注意力作为基本组件的基于Transformer的方法擅长于建模图像块之间的长程依赖关系。然而,学习长程依赖关系通常会因缺乏局部性而导致面部纹理恶化。因此,一个自然的问题是:如何有效地结合CNN和Transformer的优势以更好地重建面部?为了解决这个问题,本文试图构建一种新的网络结合两类架构的优势。如图1所示,我们所提出的ELSFace方法相比CNN架构(图1中带*的模型)的方法有更好的低频轮廓还原,相比Transformer方法(图1中带†的模型)有更好的高频细节表示。

2.方法简介

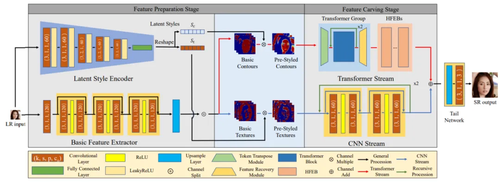

图2 本文提出的ELSFace的网络架构

本文提出了一种基于 Transformer 和卷积神经网络联合高效特征提取的人脸超分辨率重建方法 ELSFace。该方法旨在通过简洁高效的网络结构结合 Transformer 和 CNN 两种架构各自提取人脸特征的优势,以有效增强提取人脸轮廓与人脸纹理,并高质量地实现人脸超分辨率重建任务。如图2所示,该框架由特征准备阶段和特征雕刻阶段组成。

特征准备阶段:

特征准备阶段主要生成基本面部轮廓和纹理,该阶段包含一个由卷积层和ReLu激活函数层组成的基本特征提取器和一个隐风格编码器。通过潜隐风格引导,以便在重建中更好地表示面部细节。

特征雕刻阶段:

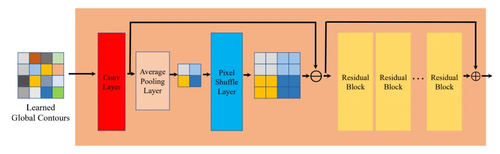

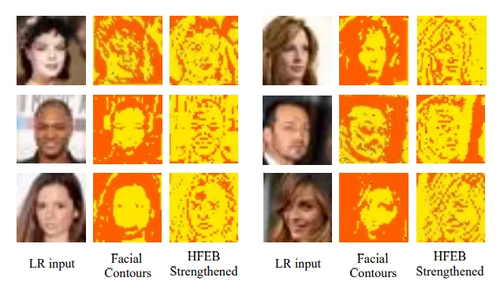

在特征雕刻阶段,CNN和Transformer流分别以并行递归方式用于单独恢复面部纹理和面部轮廓。这种设计能够有效的将输入特征拆分成高频的人脸细节特征和低频轮廓特征进行处理,并且递归设计能够更高效的利用模型参数。考虑到Transformer流中学习长程依赖关系时忽略了高频特征,本文在Transformer流中设计了高频增强块(HFEB),其结构如图3所示,HFEB能够利用残差相减的方式增强轮廓特征中的高频细节,效果如图4所示。

循环递归机制:

方法中的两条支路分别引入了循环递归机制,旨在有限的计算资源下更充分地增强提取人脸轮廓和人脸纹理,并让方法本身在重建推理中更加高效与轻量化。独立增强雕刻的人脸纹理与人脸轮廓由尾部网络整合成三通道的输出。

图3 本文提出的HFEB模块结构

图4 HFEB模块对脸部细节的增强效果

锐化损失函数:

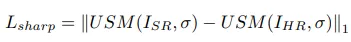

为了强化人脸细节,本文提出一种锐化损失函数,将超分结果和GT图像通过USM锐化增强,并利用损失函数约束两者的L1距离,其公式如下所示:

3. 实验分析

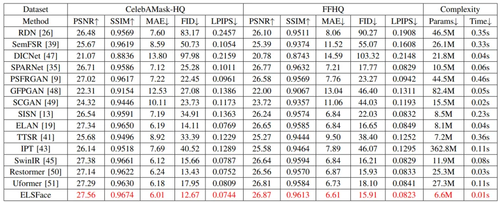

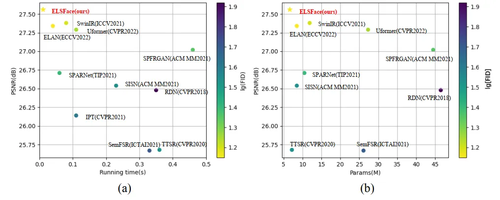

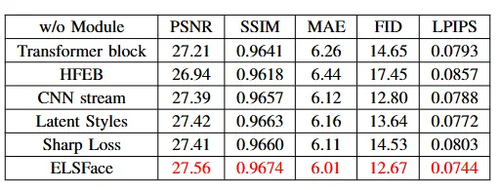

本文在CelebAMask-HQ和 FFHQ两个人脸超分数据集上验证了ELSFace的优异能力。实验结果如下,证明了方法的有效性。

表1 所提方法在两个主流数据集上的实验结果

我们还在真实场景照片上进行超分实验,效果如图5所示。

图5 真实图像上的超分效果

结合效率指标与散点图也可以发现,方法的参数量和推理时间在优异性能的前提下也都达到了最优,证明了平行结构和循环递归模式对方法运行效率的改善是有效的。

图6 ELSFace同其他方法在模型性能与推理效率上的关系比较

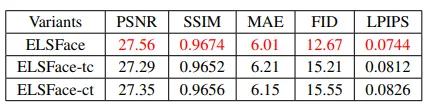

此外,消融实验(表2)也证明了各个模块的设计对于人脸超分任务均是必要的。

表2 所提方法各个模块消融实验

最后,进一步消融实验表明循环结构能够充分利用模型的参数(如表3所示),ELSFace中,采用CNN和Transformer架构并行设计优于串行设计方式(如表4所示)。

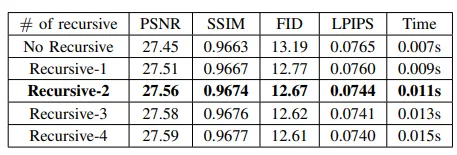

表3 循环次数消融实验

表4 并行和串行设计消融实验

04

A Semi-Supervised Underexposed Image Enhancement Network with Supervised Context Attention and Multi-Exposure Fusion

作者:

史媛媛,扶小龙,李宇楠*,苗凯彬,刘向增,赵博程,苗启广

单位:

西安电子科技大学

邮箱:

yuanyuan_shi@stu.xidian.edu.cn;

论文:

https://ieeexplore.ieee.org/abstract/document/10130339

*通讯作者

1.摘要

图像增强技术已经取得了令人瞩目的进展。然而,大部分方法仍然依赖于监督学习,这需要大量成对的数据。同时,在现实世界的复杂光照条件下,这些基于合成图像训练的方法无法在极暗或极亮的区域恢复细节,导致曝光误差。传统的训练损失处理将所有像素等同对待,这导致结果中边缘模糊。为了应对这些挑战,本文提出了一种有效的半监督框架,专门用于欠曝图像的增强。我们的网络框架包含一个监督分支和一个非监督分支,两者共享权重,能够充分利用成对和大量非成对的数据。此外,我们设计了一个多曝光融合模块,能够自适应地融合校正后的图像,解决在某些极端情况下出现的低对比度和色彩偏见问题。我们还提出了一个监督性的上下文关注模块,更有效地使用边缘信息作为监督,以精确恢复图像细节。

2. 方法

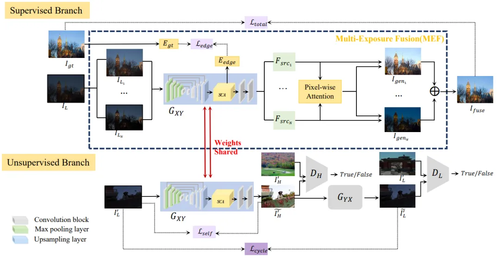

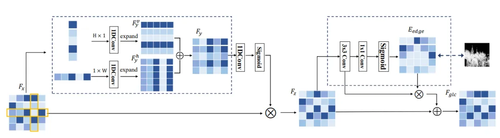

图1 半监督网络架构框架图

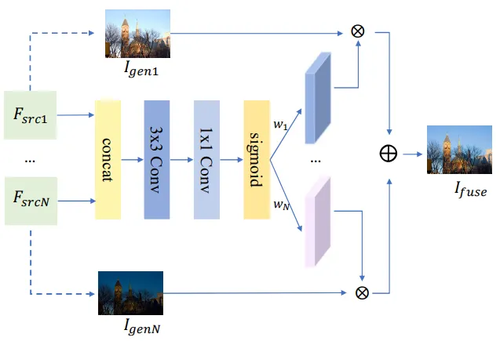

本文所提半监督网络架构框架如图1所示,由监督学习分支和非监督学习分支组成,且在训练期间这两个分支共享生成器的权重。监督和非监督分支中的共享权重部分可以帮助监督分支减少对数据集的依赖,并提高监督分支的泛化性能。为了解决严重欠曝图像中细节丢失的问题,我们设计了一个多曝光图像融合模块。该模块由两部分组成:生成和融合。在生成部分,我们合成一组具有不同曝光的图像并将它们输入生成器以生成曝光校正图像。 如图2所示,在融合部分,我们引入融合模块来自适应地融合校正后的图像以提升视觉质量。在非监督学习分支中,使用带自保持损失的循环生成对抗网络来训练非成对数据。生成器与监督部分共享。此外,我们引入了监督性上下文注意(SCA)模块来解决边缘细节模糊的问题。SCA模块包括一个条带池化模块和一个由先验边缘图监督的局部注意力模块。条带池化可以聚集图像的全局线索,从而提高边缘的一致性。通过边缘损失学习的局部注意力将更多地聚焦于边缘,并生成具有更精细细节的图像。我们在图3中给出了监督性上下文关注(SCA)模块的详细架构。

图2 基于像素级注意力机制的融合方法

图3 监督性上下文注意模块

所提出的监督上下文注意模块的结构如图3所示。 在该模块中,我们通过将局部注意力子模块附加到条带池子模块来提取局部和全局信息。 然后提供边缘监测信号来增强边缘信息,使得增强后的图像边缘更加清晰。

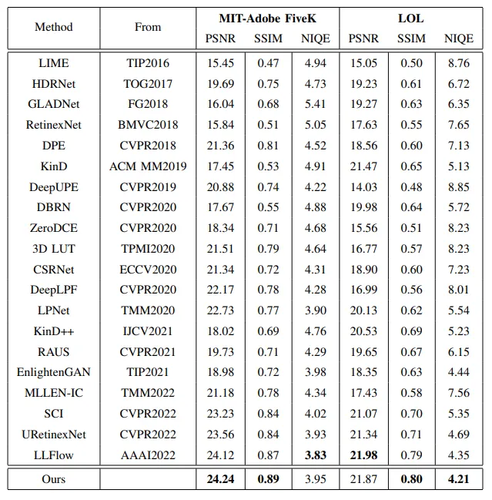

3. 实验

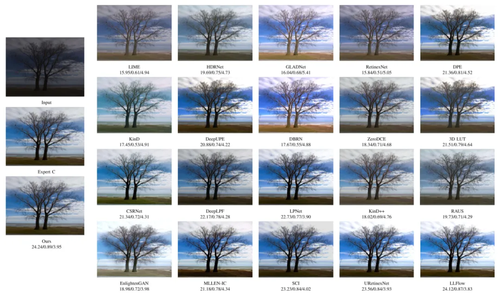

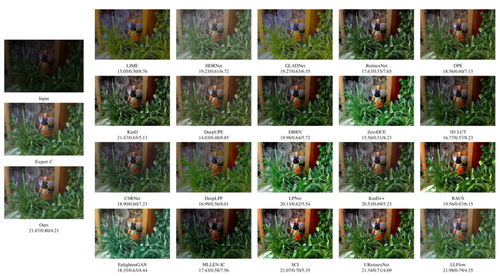

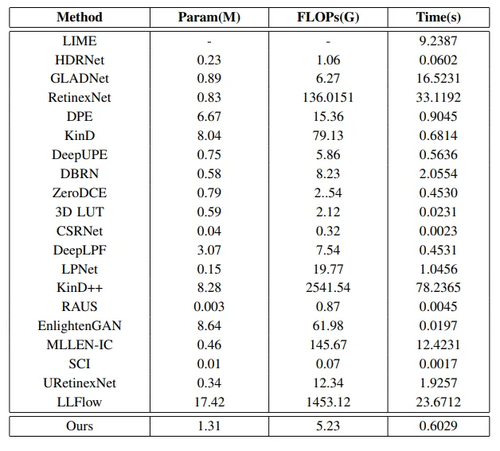

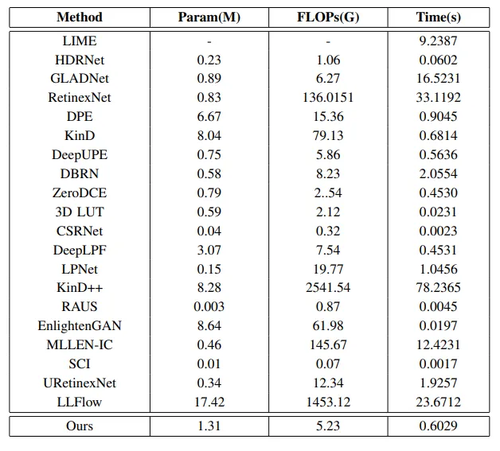

我们在MIT-Adobe FiveK和LOL数据集上进行了定性与定量比较,表1提供了本方法与20种方法PSNR、SSIM和NIQE指标的定量比较,图4,图5提供了在两个数据集测试集上的视觉比较。此外,为了证明方法的鲁棒性,本方法还在MIT-Adobe FiveK训练集上训练,在DICM , NPE , MEF, and VV 这5个主流合成测试集上进行实验,表2提供了与先进方法的NIQE比较。图6提供了在真实拍摄的图片上各种方法相应的视觉比较。为了比较各个方法的效率,我们还在表3验证了我们的方法与其他先进方法在模型大小,推理速度以及性能上的综合权衡。可以看出,我们的半监督图像增强算法在与竞争方法的比较中都能取得较好的结果,并且在模型效率的权衡上也有均衡的表现。

表1 与最先进的图像增强方法在MIT-Adobe FiveK和LOL数据集上的定量比较。最优结果以粗体表示。

图4 在MIT-Adobe FiveK数据集的测试图像上与最先进的方法进行视觉比较

图5 在LOL数据集的测试图像上与最先进的方法进行视觉比较

表2 在基准数据集上与先进方法的NIQE比较

图6 在真实拍摄的(亚麻地毯)图像上与最先进的方法进行视觉比较

表3 与最先进的图像增强方法在MIT-Adobe FiveK数据集上的效率评估。

05

Few-Shot Class-Incremental Audio Classification Using Dynamically Expanded Classifier With Self-Attention Modified Prototypes

基于自注意力调整原型的动态扩展分类器的小样本类别增量音频分类

作者:

李艳雄1、曹文昌1、谢伟1、李佳龙1、Emmanouil Benetos2

单位:

1华南理工大学、2QueenMary University of London

邮箱:

eeyxli@scut.edu.cn;wenchangcao98@163.com;

chester.w.xie@gmail.com;lijialongjy@163.com;

emmanouil.benetos@qmul.ac.uk

论文:

https://ieeexplore.ieee.org/document/10135116

代码:

https://github.com/vinceasvp/FCAC

实验数据集地址:

https://www.modelscope.cn/datasets/pp199124903/FSC-89/summary

https://www.modelscope.cn/datasets/pp199124903/LS-100/summary

https://www.modelscope.cn/datasets/pp199124903/NSynth-100/summary

1. 研究背景

音频分类是音频信息处理领域的一个重要问题,受到学术界和工业界科研人员的广泛关注。现有的大多数音频分类方法假设待分类的音频类别是固定的。当出现新的(未见过的)音频类别时,需要使用所有音频类别的大量带标签样本重新训练音频分类系统,才能识别旧类和新类。如果新类持续出现,现有音频分类方法将变得低效甚至不可行。为了解决上述问题,本文提出了一种基于自注意力调整原型的动态扩展分类器的小样本类别增量音频分类方法。该方法可以增量识别新类且不会忘记旧类。

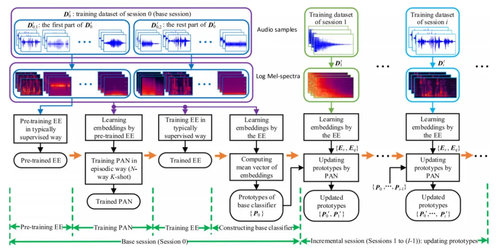

2. 方法概述

本文将音频分类模型解耦成表征提取器(Embedding Extractor, EE)和可扩展原型分类器(由各类的原型构成,每个原型代表一个类),并设计一个用于更新分类器的原型自适应网络(Prototype Adaptation Network, PAN)。如图1所示,在基础环节(Base session),充分利用基类(Base classes)的大量训练样本训练表征提取器和原型自适应网络。其中,表征提取器和原型自适应网络分别以监督学习(Supervised Learning)和情景式学习(Episodic learning)的方式进行训练。在增量环节(Incremental session),以冻结表征提取器(不更新参数)的方式缓解模型的灾难性遗忘问题;同时采用原型自适应网络动态更新旧类和新类的原型,实现可扩展原型分类器的更新。方法详情请参见论文。

图1 本文提出的小样本类别增量音频分类方法框图

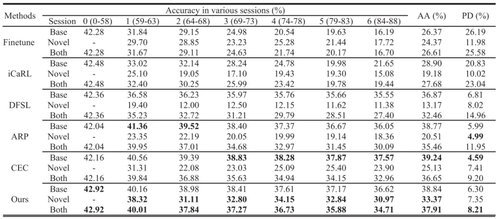

3. 实验结果

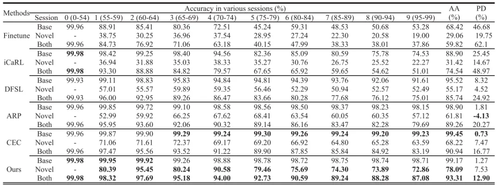

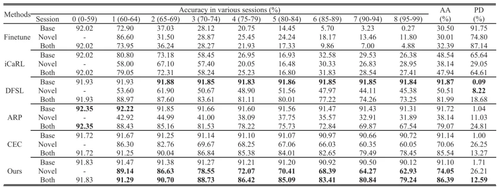

采用FSC-89、NS-10和LS-100三个公开数据集评测各方法的性能。不同方法在三个数据集上的平均精度(Average Accuracy, AA)和性能下降率(Performance Dropping rate, PD)分别如表1、表2和表3所示。实验结果表明:与目前主流方法相比,本文方法在所有类(Both)上取得了更高的AA值和更低的PD值。总之,本文方法在保持对旧类准确识别的情况下,还能连续学习新类,使模型具备稳定性高且适应性强的能力。更多的实验结果与分析请参见论文。

表1 不同方法在FSC-89数据集上的结果

Base: 基类;Novel: 新类;Both: 所有类。

表2 不同方法在NSynth-100数据集上的结果

表3 不同方法在LS-100数据集上的结果

编辑人:吴建龙、任文琦

专委会责任副主任:张勇东